Sumário

- Dedicatória

- Capa

- Prefácio

- Introdução

- R - uma linguagem para análise de dados e gráficos

- A importância da Estatística na Medicina

- Breve História do R

- Instalação do R e do RStudio

- RStudio - primeiros passos

- Variáveis no R

- Tipos de Dados

- Funções no R

- Pacotes do R

- Data Frames

- Lendo Dados

- RStudio Projects

- Estatística Descritiva no R

- Manipulando dados no R

-

Visualizando dados - Gráficos básicos do R

- Introdução

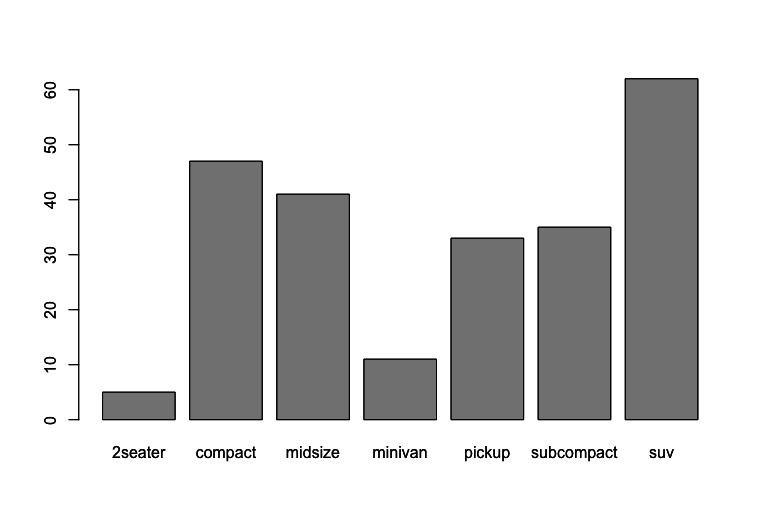

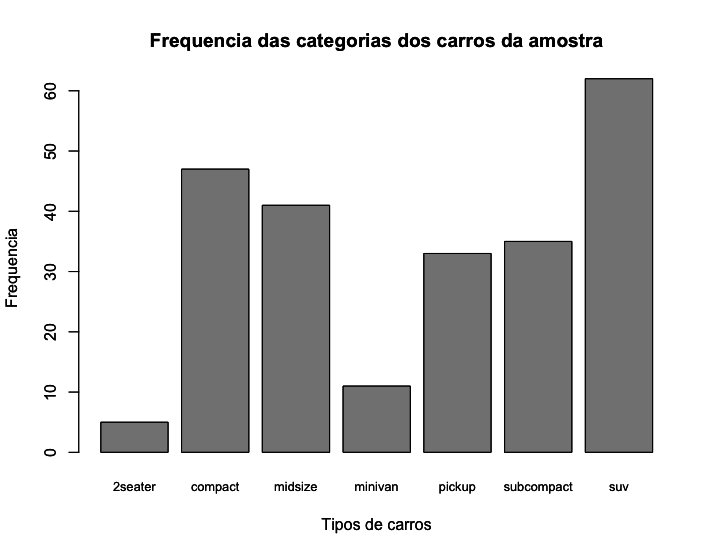

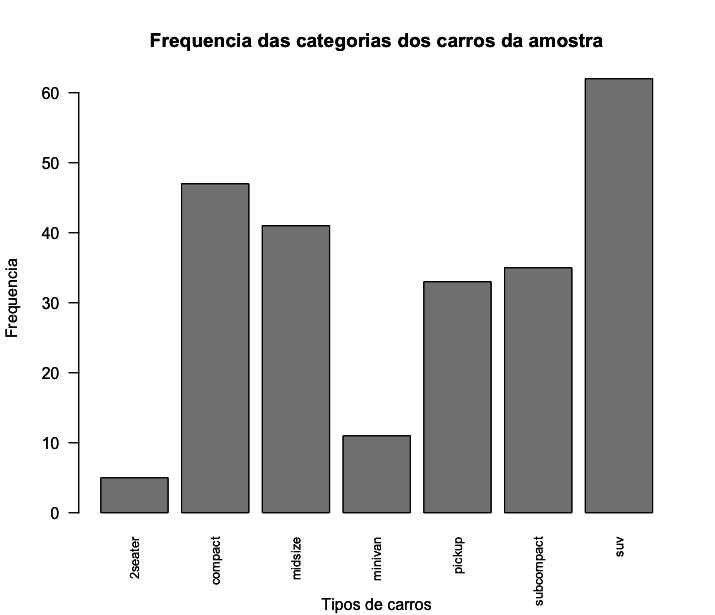

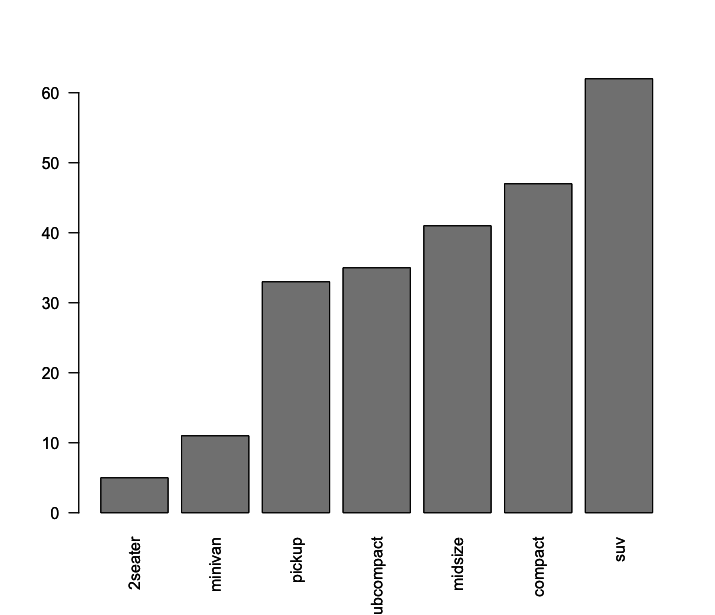

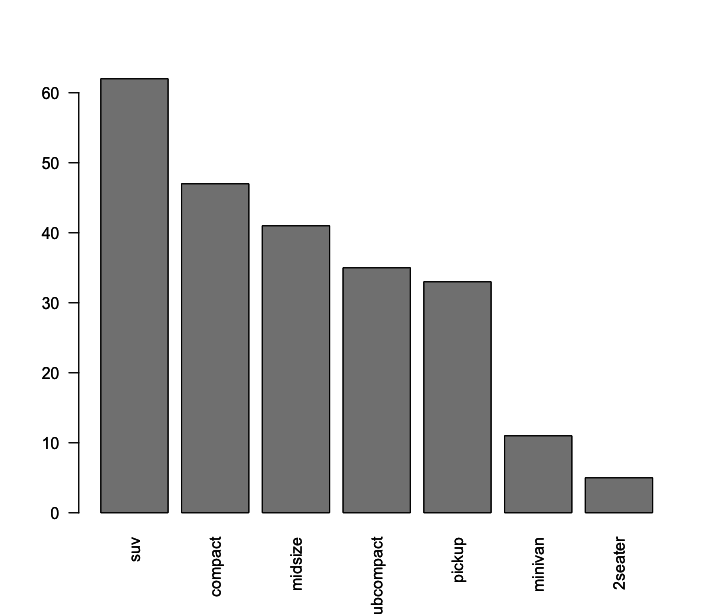

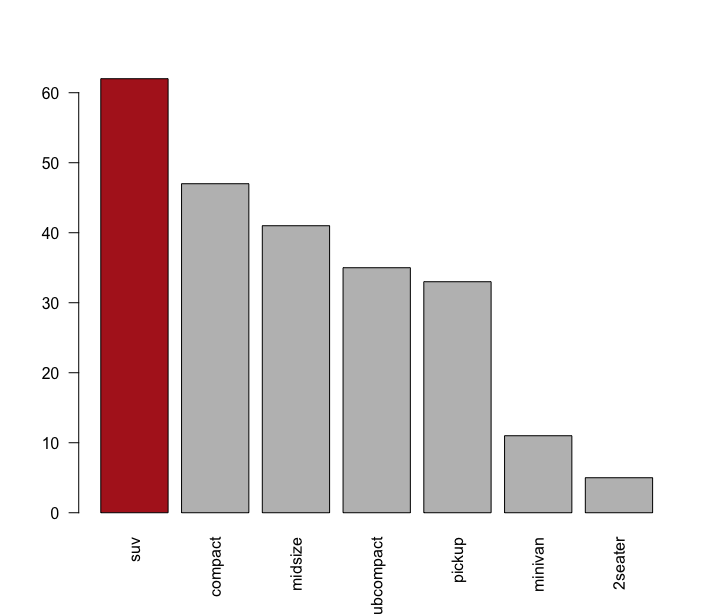

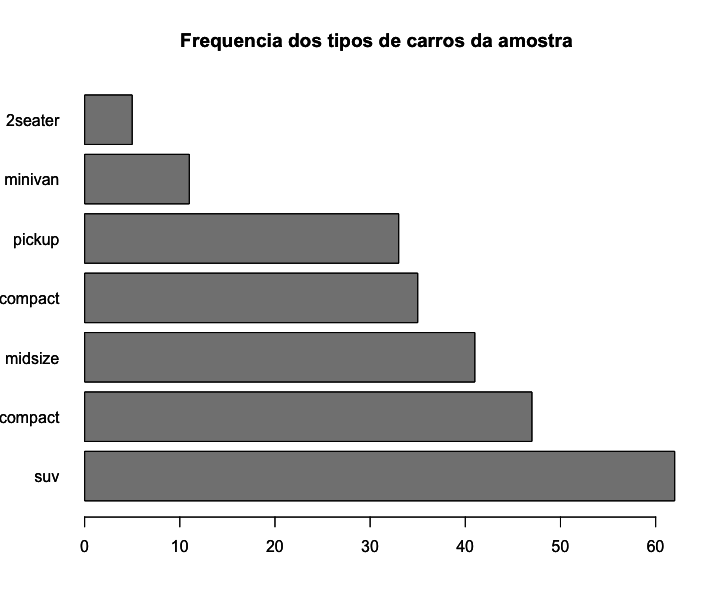

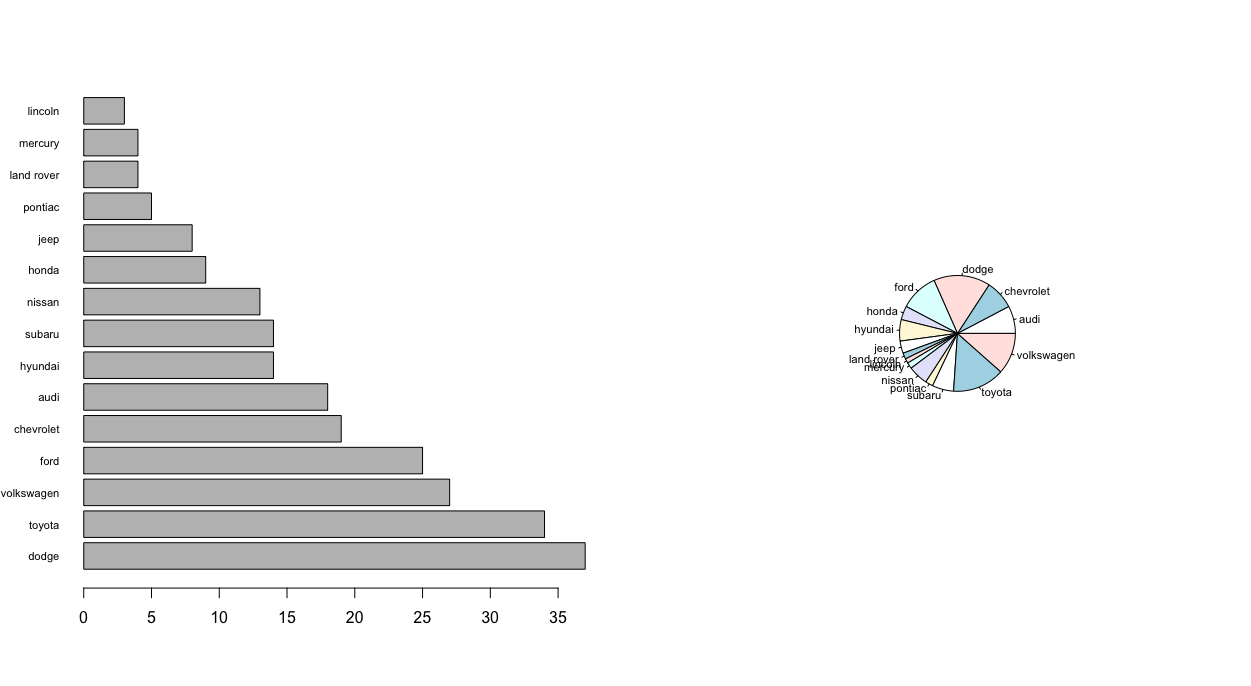

- Parte 1 - Visualizando dados categóricos.

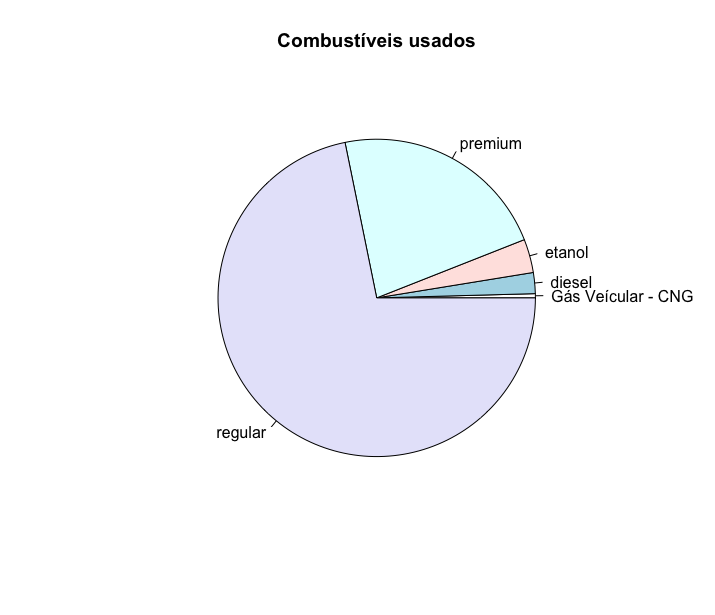

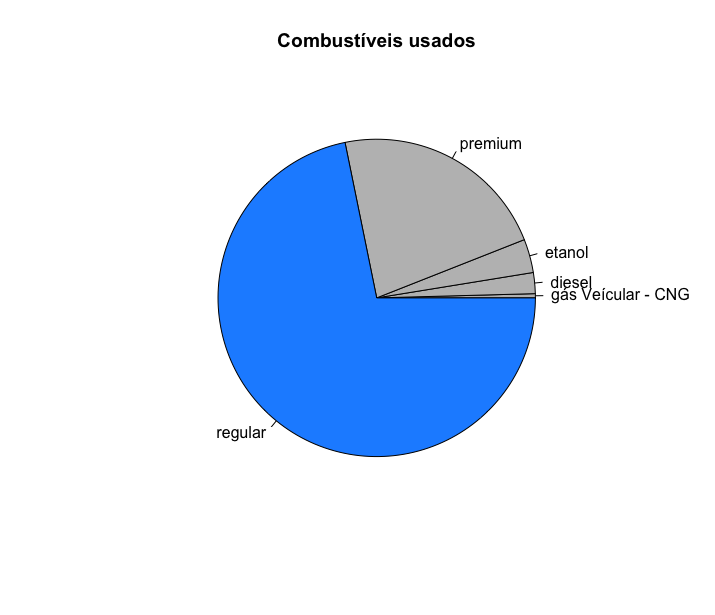

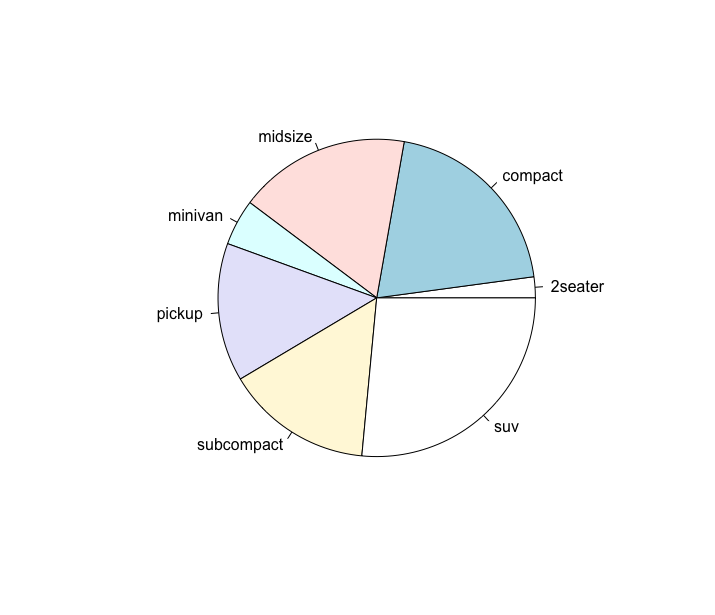

- Gráficos de Pizza - picharts

- Parte 2 - Visualizando dados numéricos

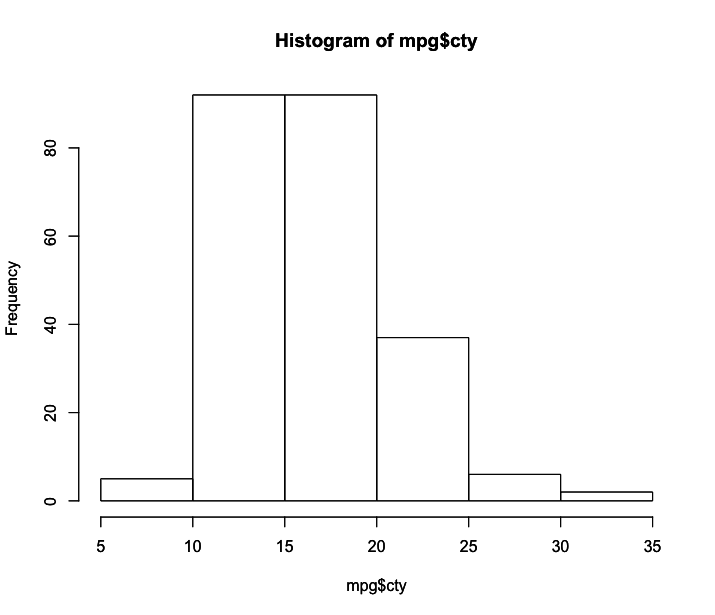

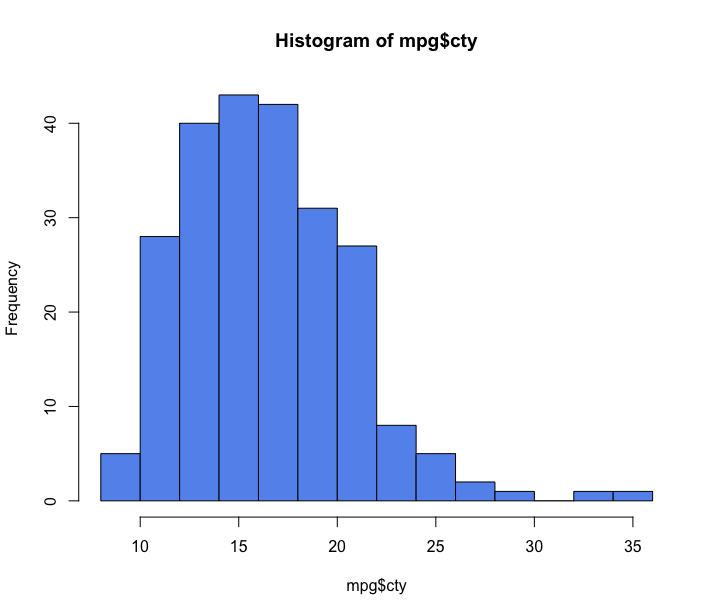

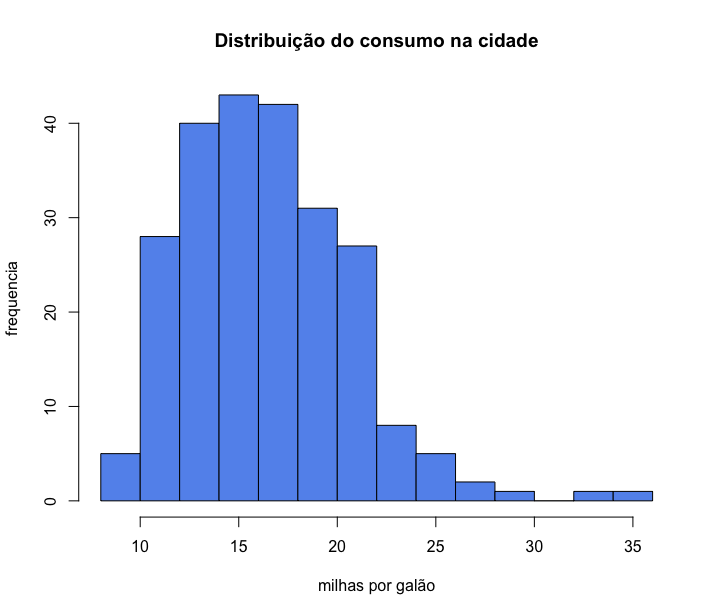

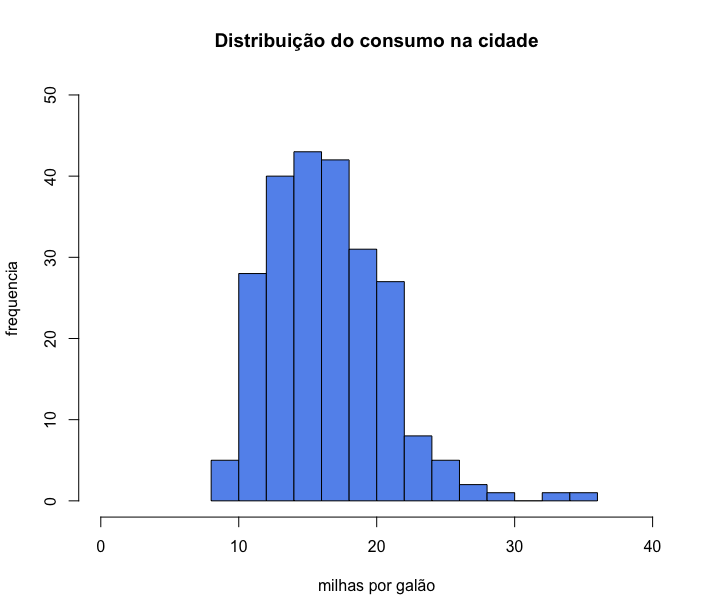

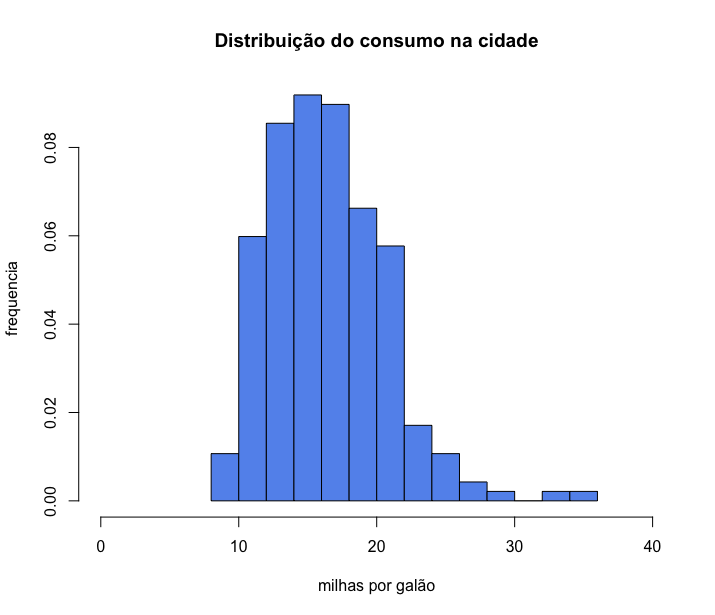

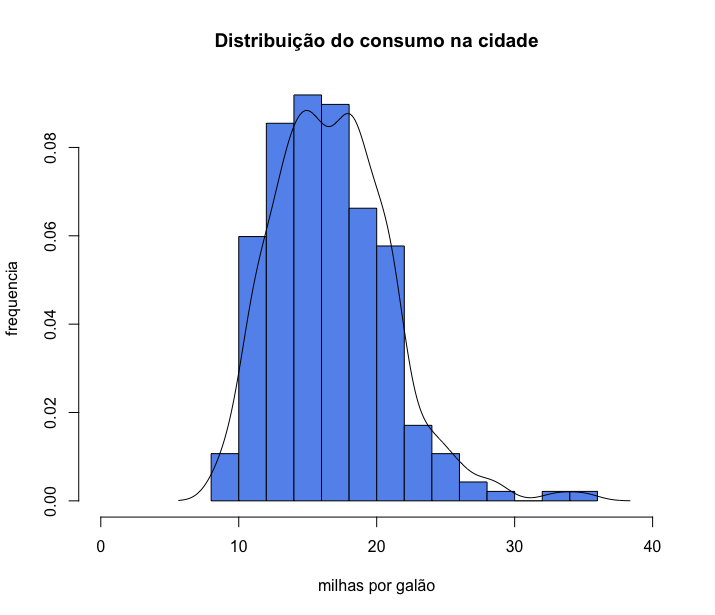

- Histogramas

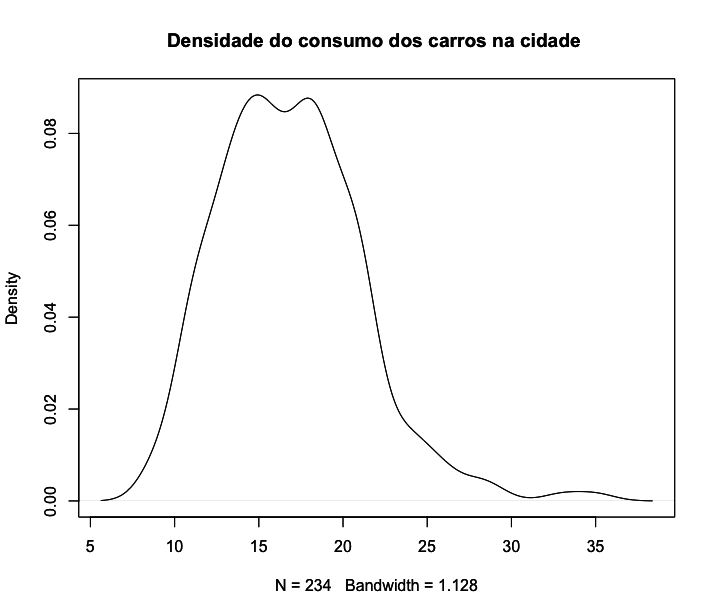

- Gráficos de densidade

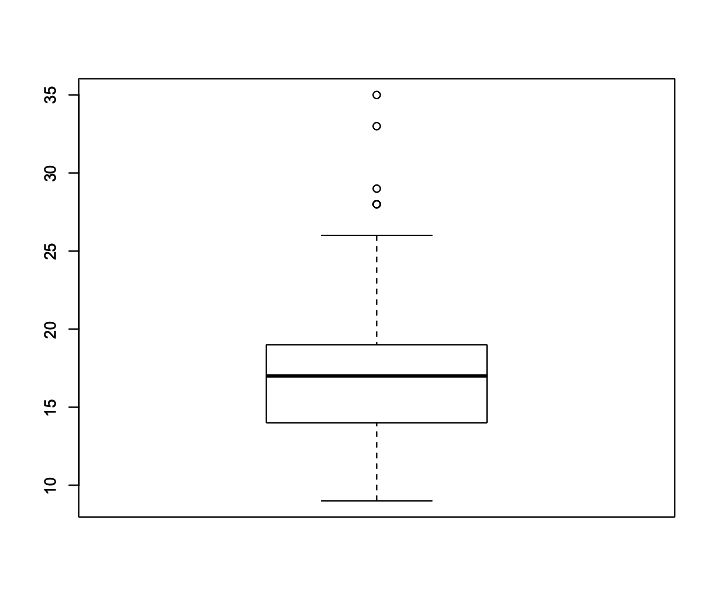

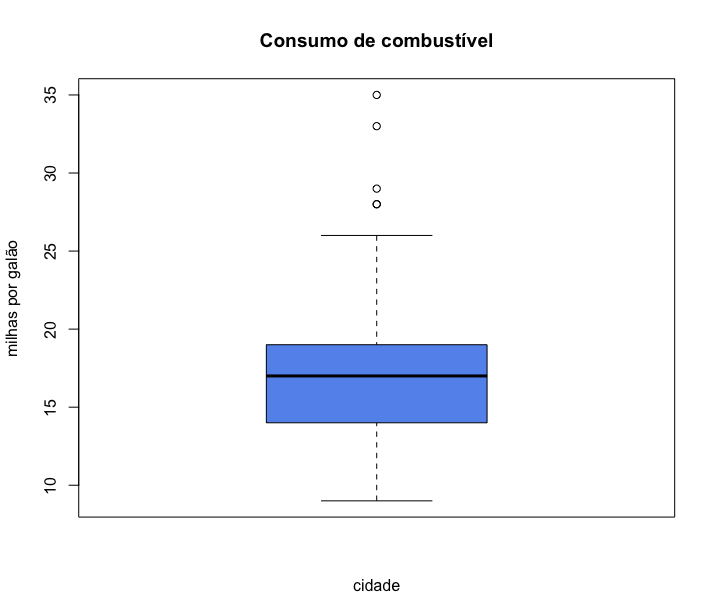

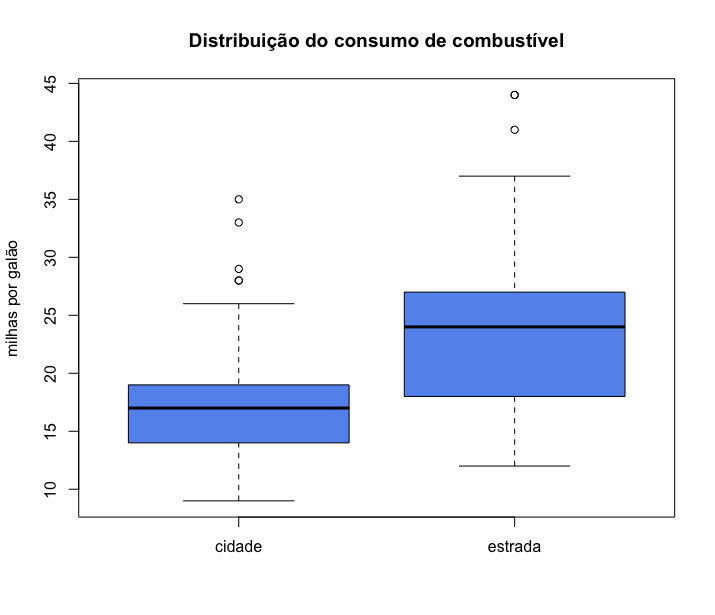

- Boxplots

- Parte 3 - Visualizando relações entre variáveis

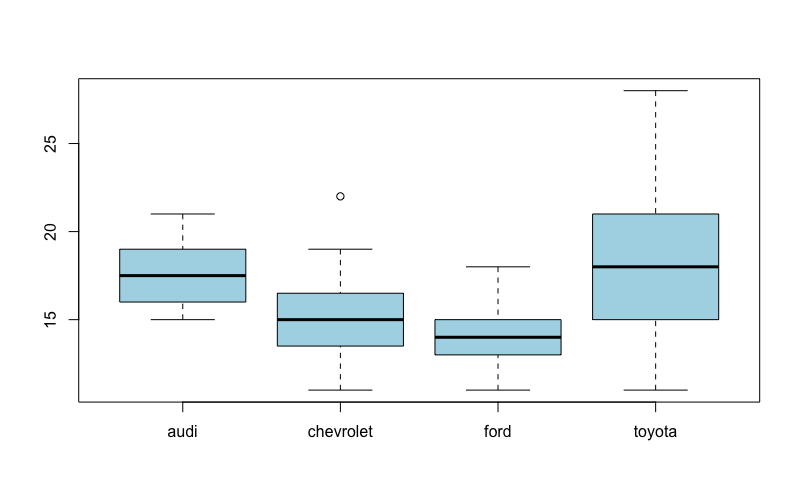

- Correlação entre uma variável numérica e uma variável categórica

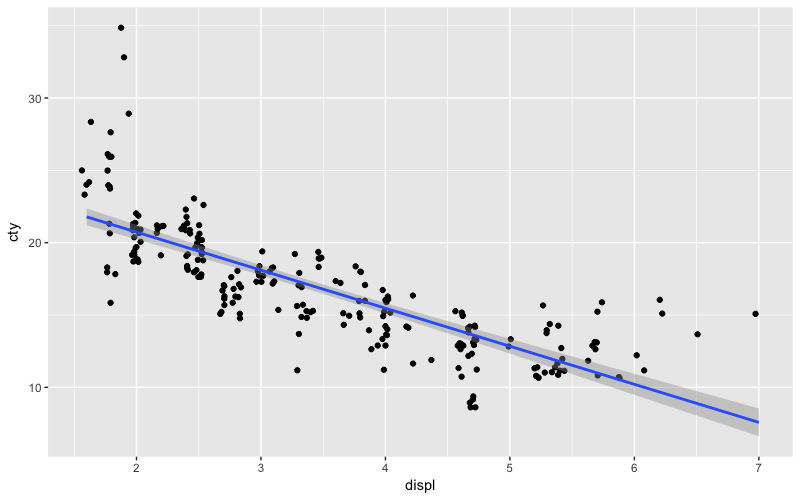

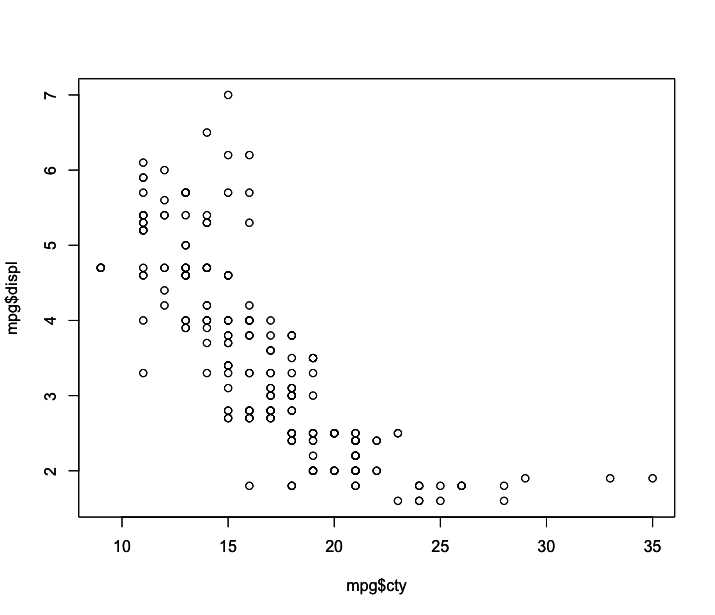

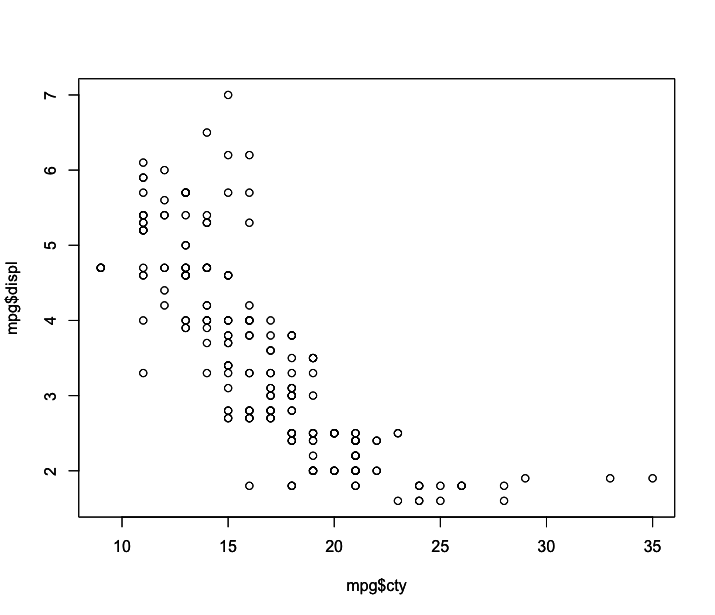

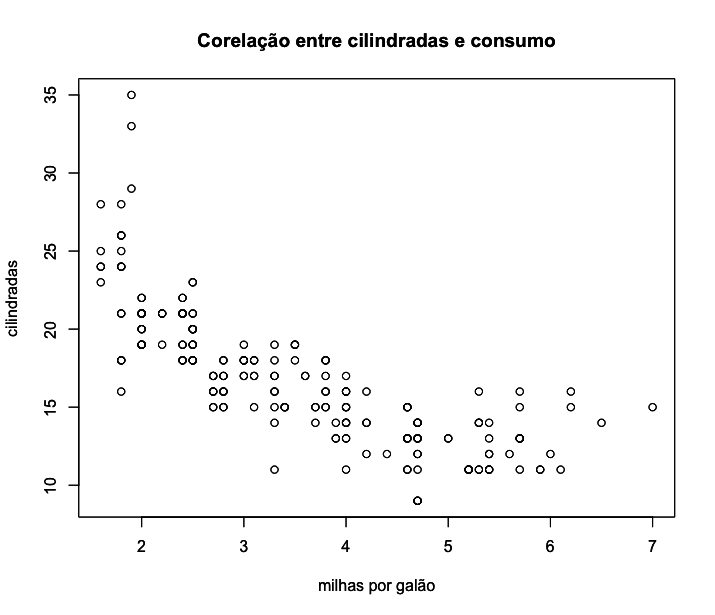

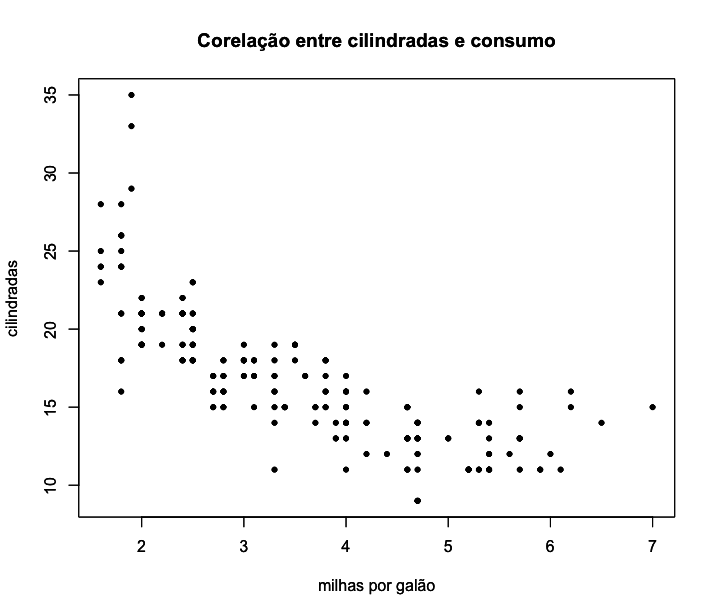

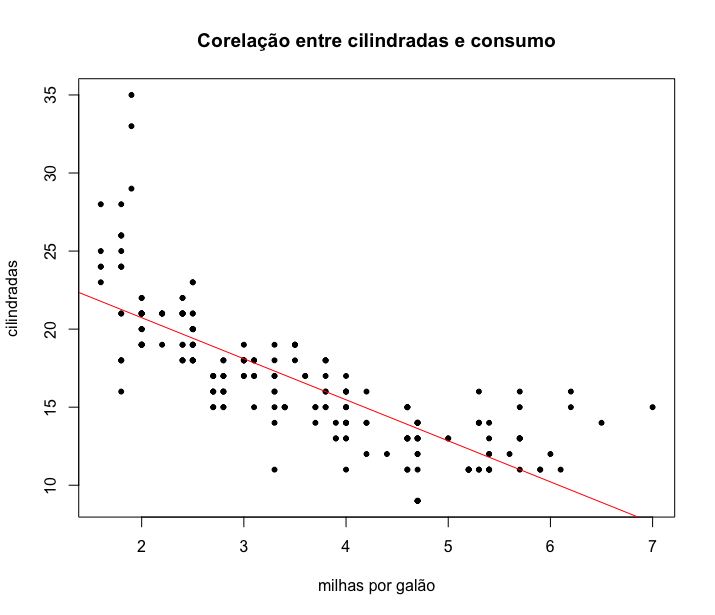

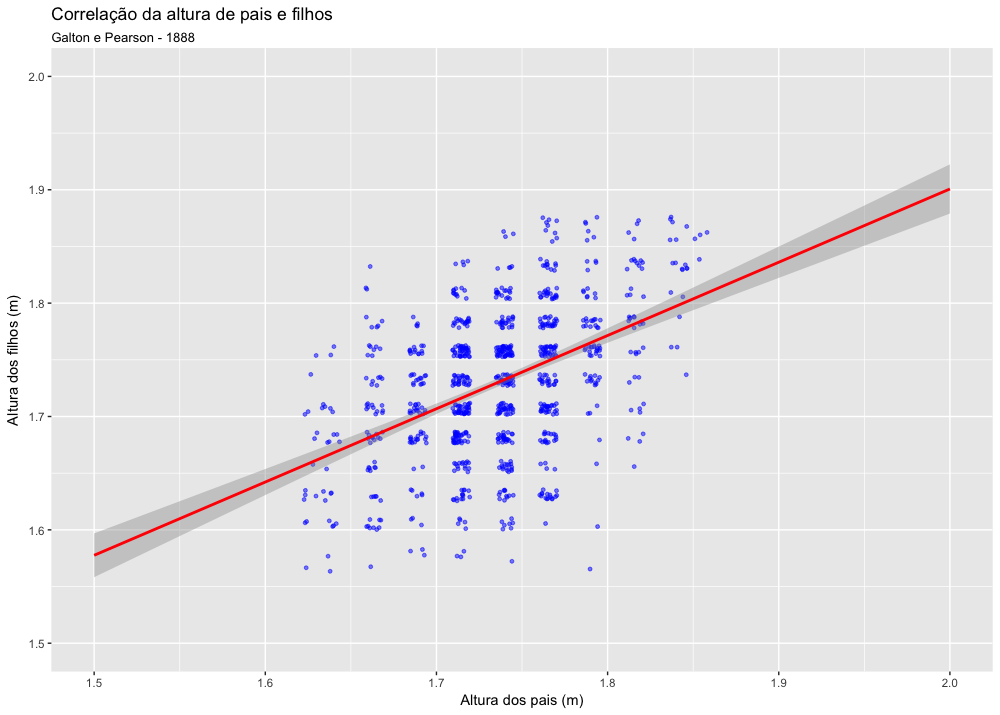

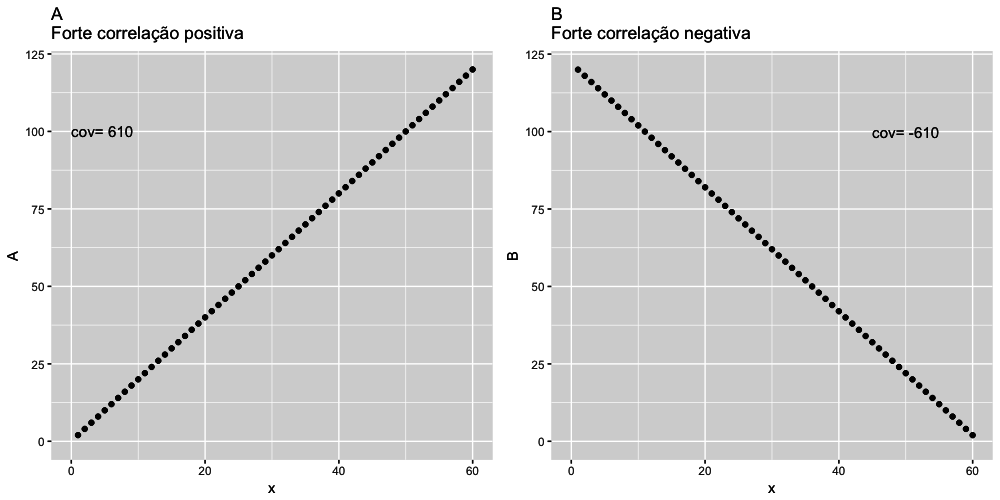

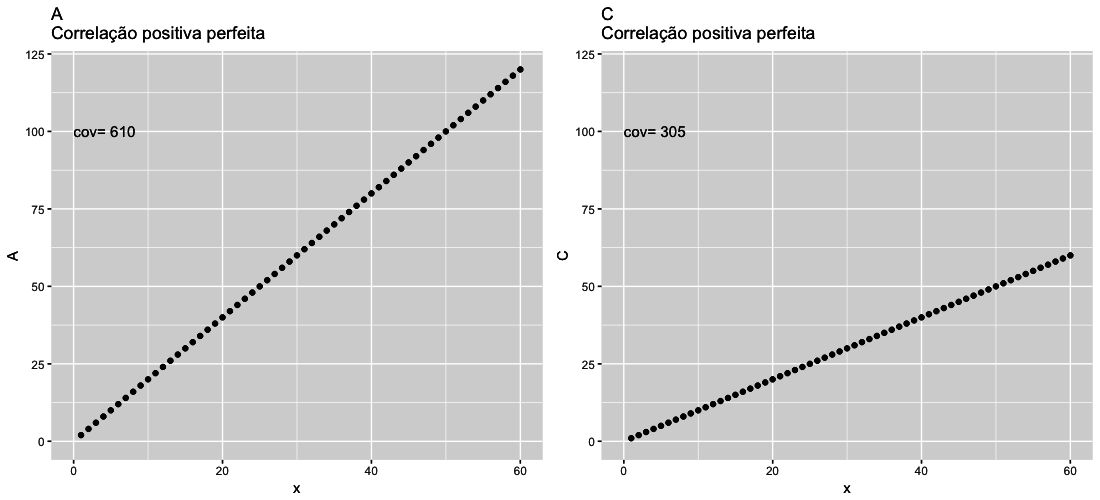

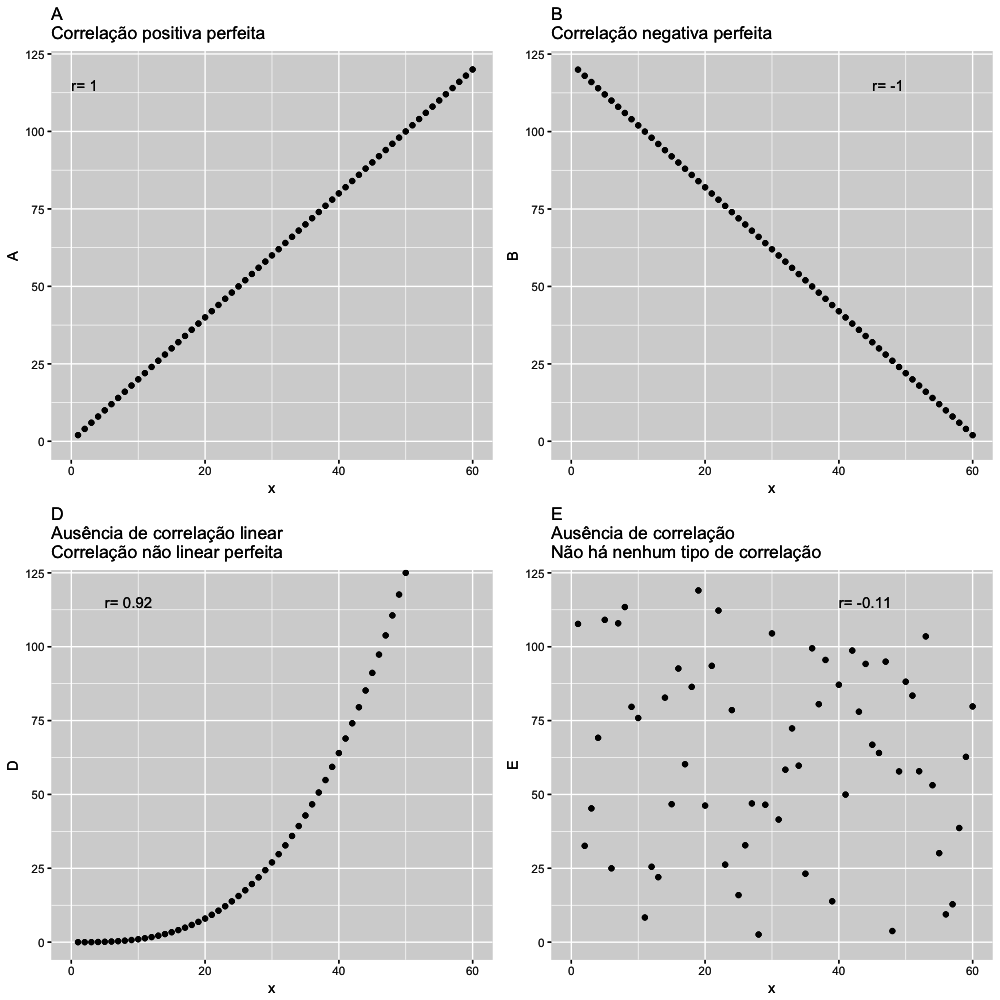

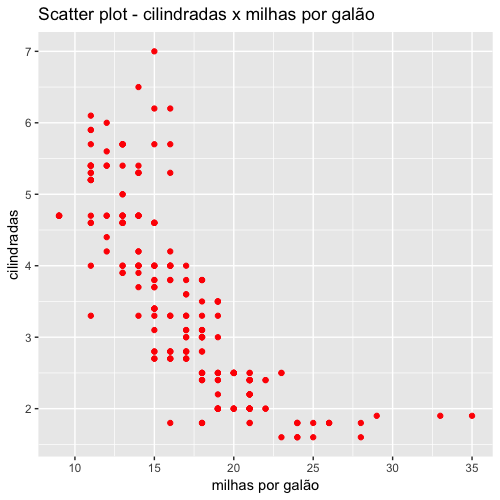

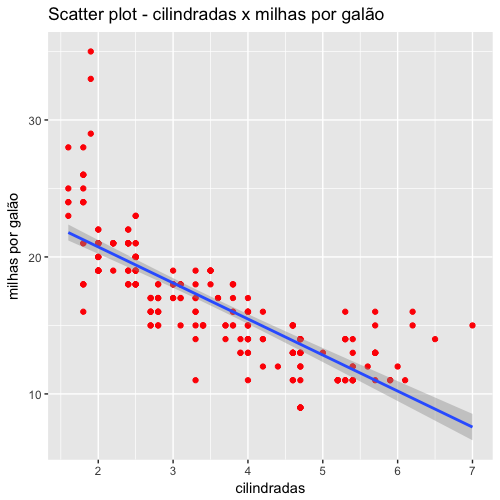

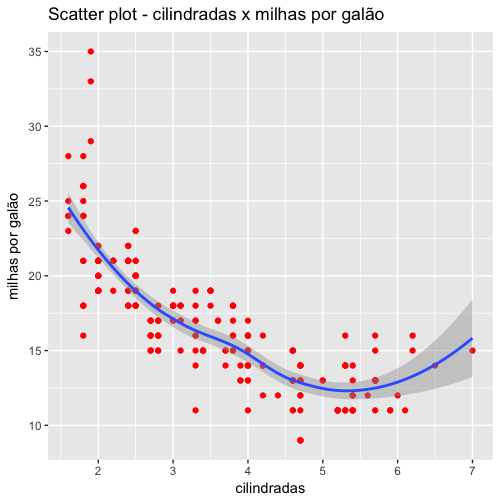

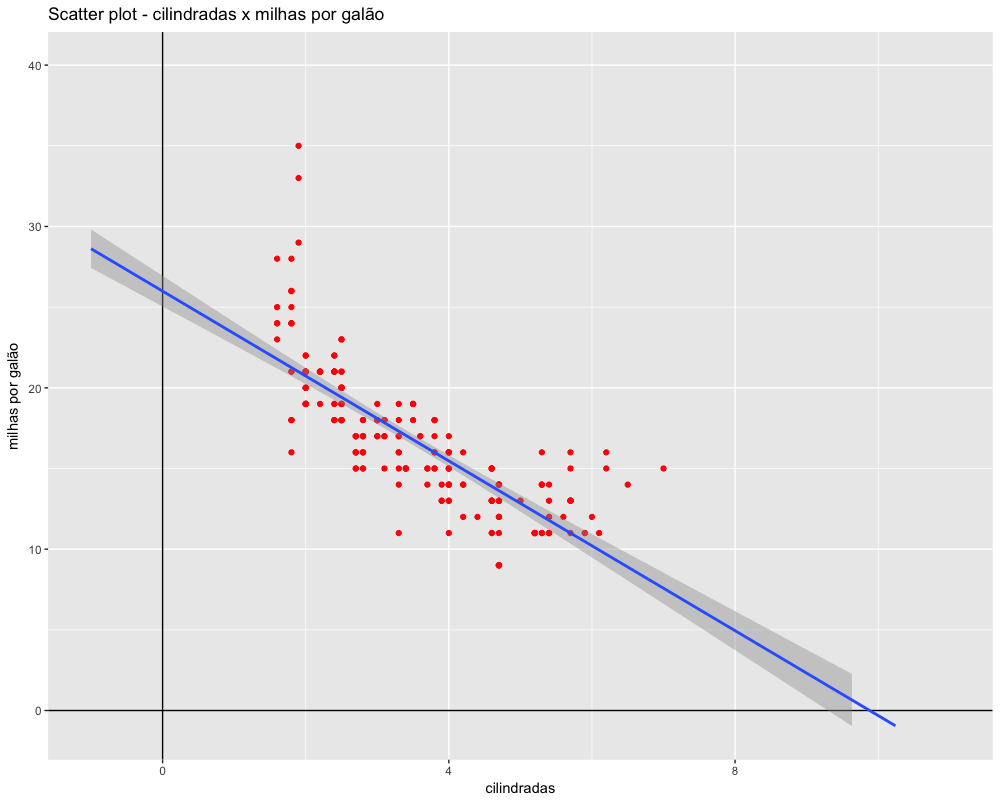

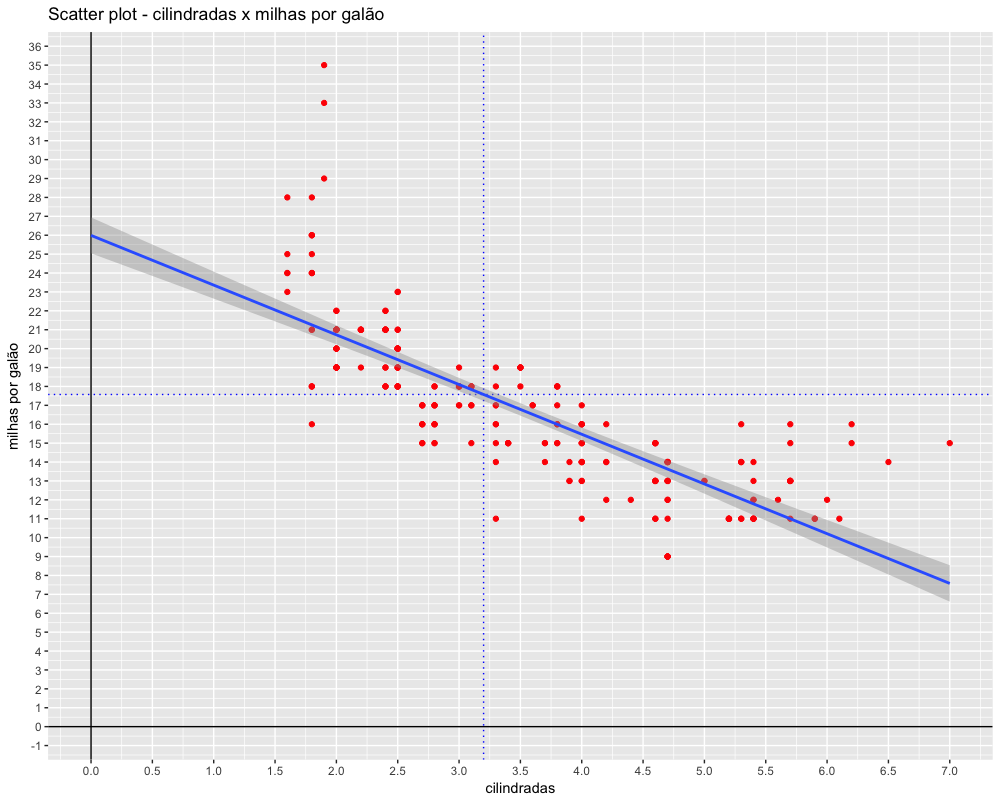

- Correlação entre duas variáveis numéricas

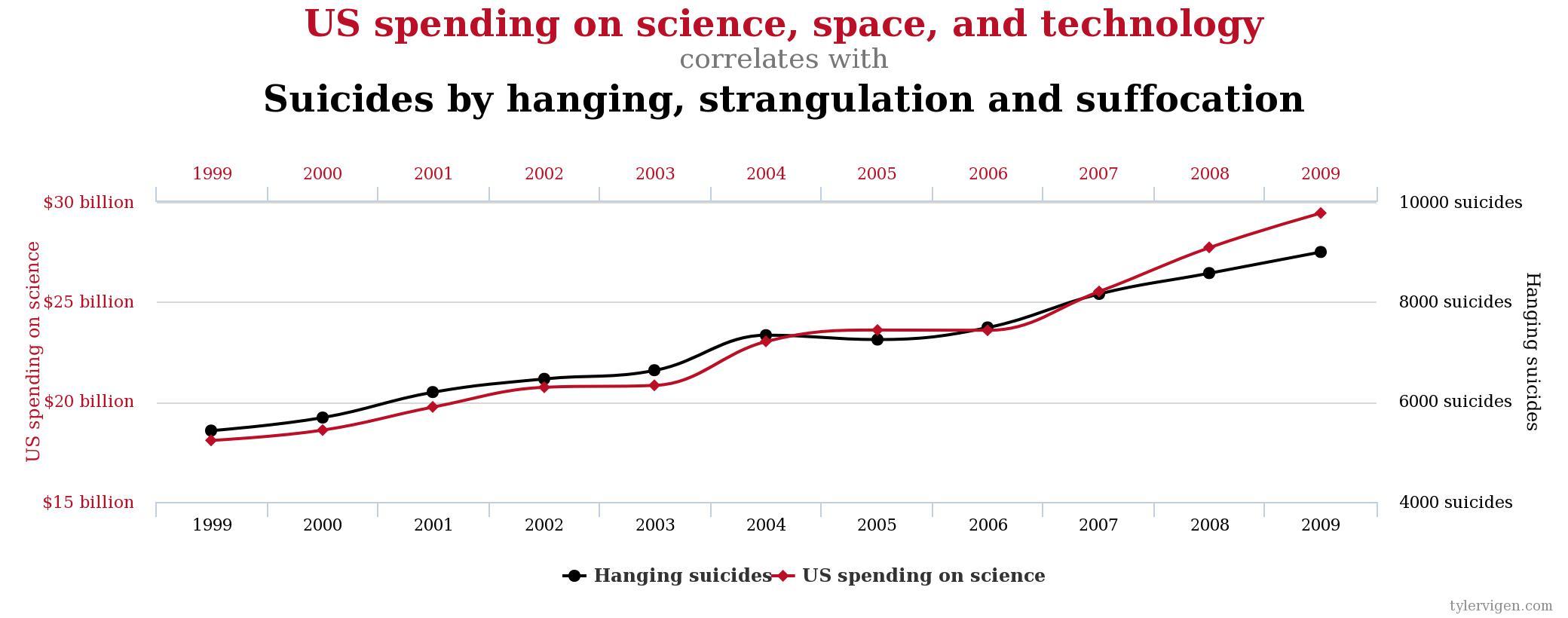

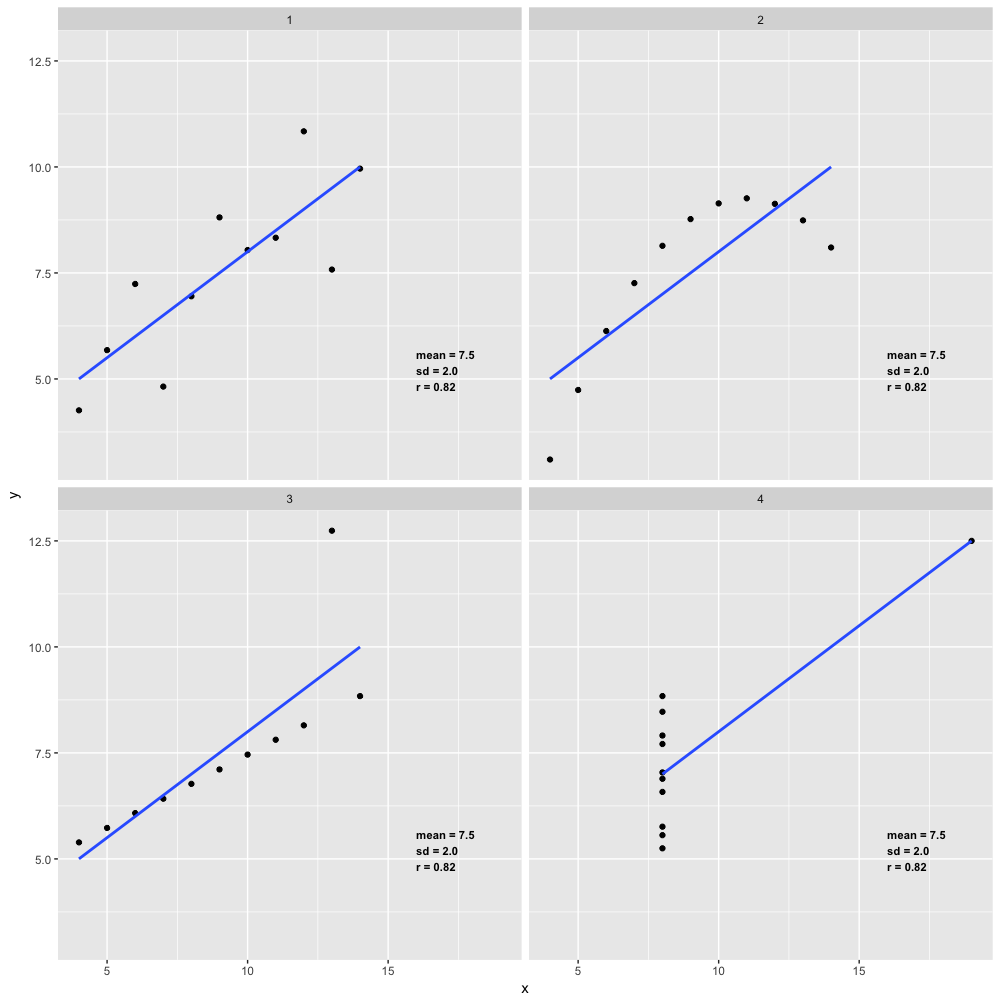

- Correlação

- Modelos Científicos

-

Distribuições de probabilidade

- Introdução

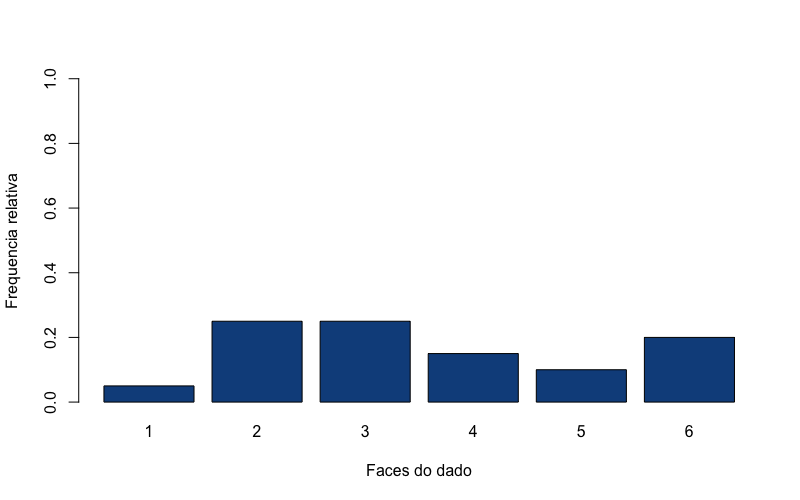

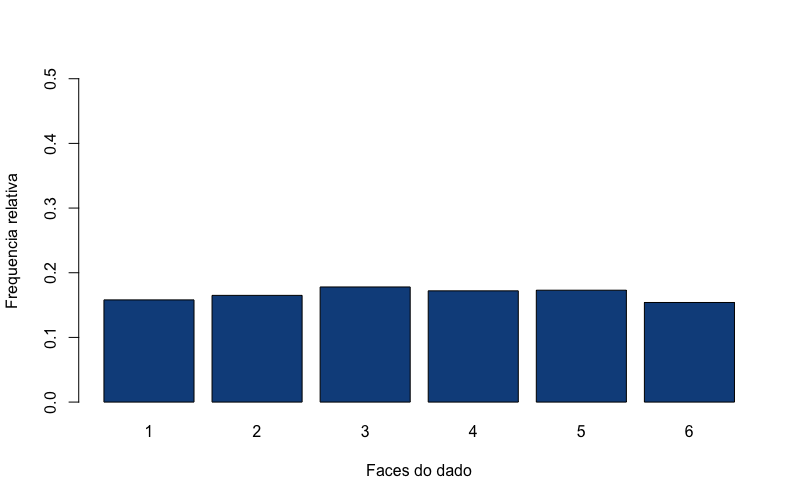

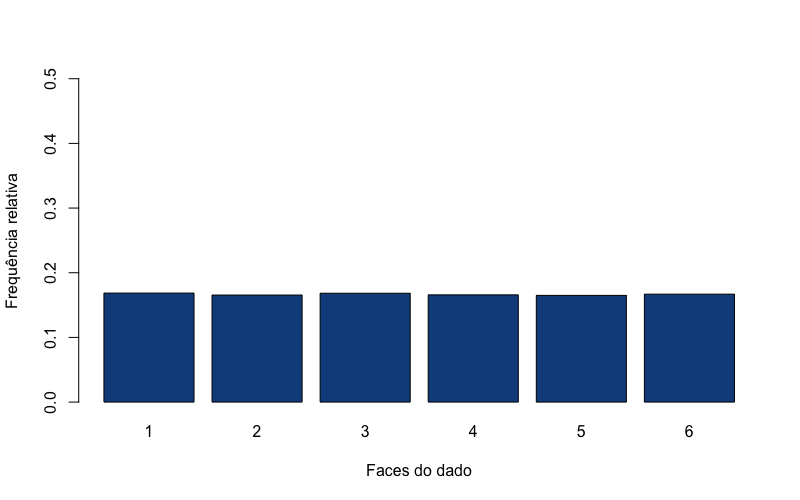

- A Distribuição uniforme e um jogo de dados

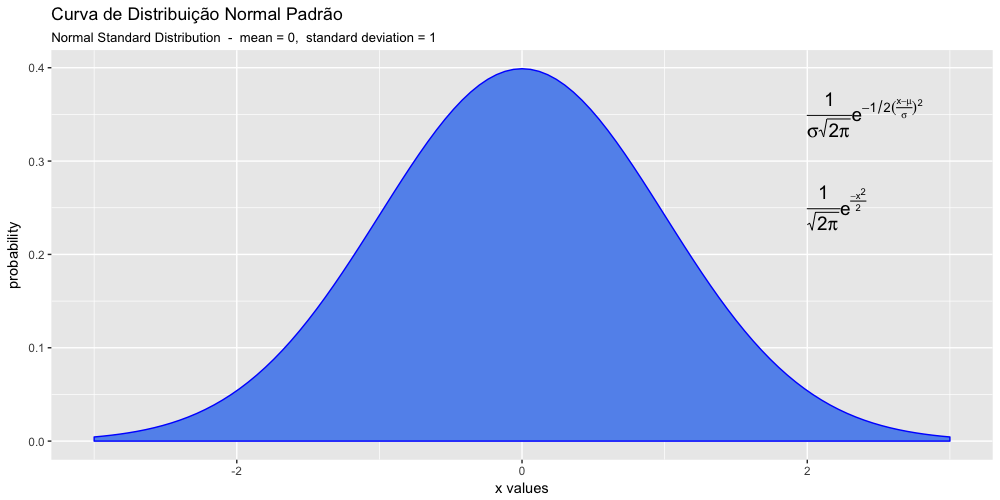

- A distribuição normal

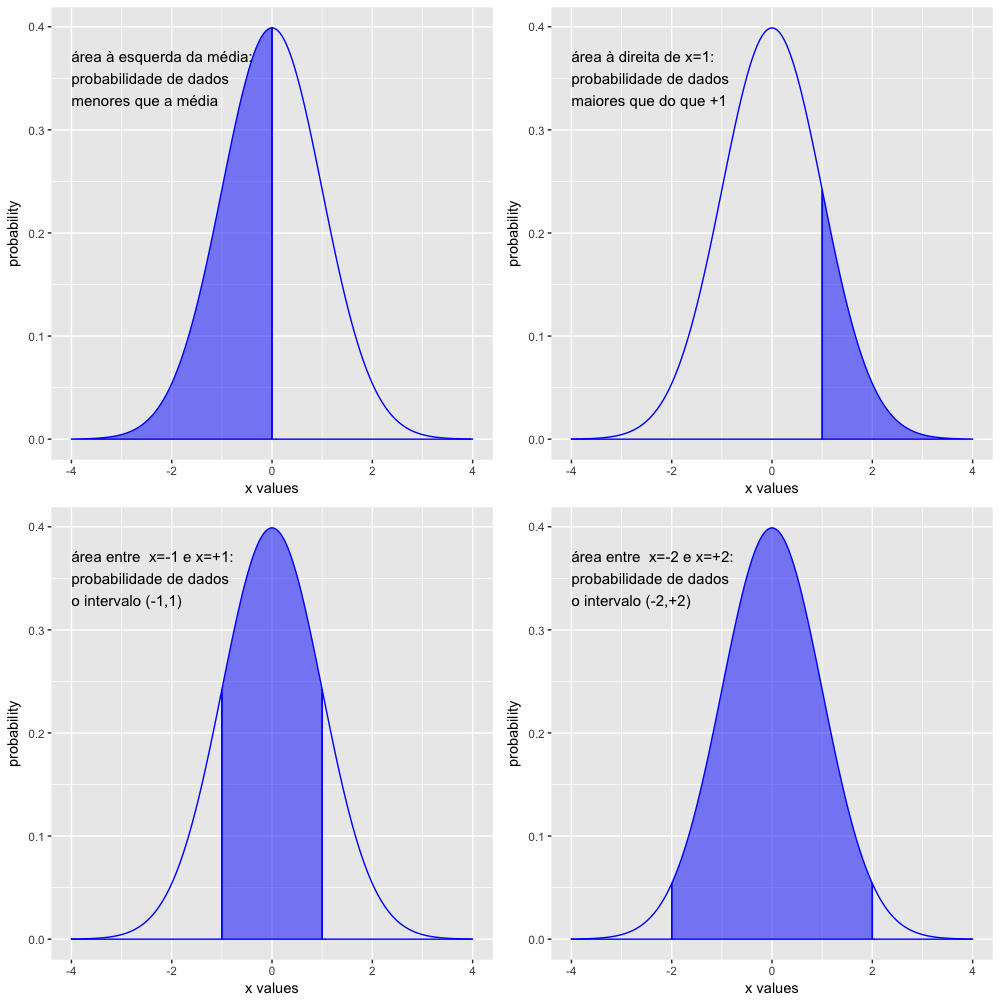

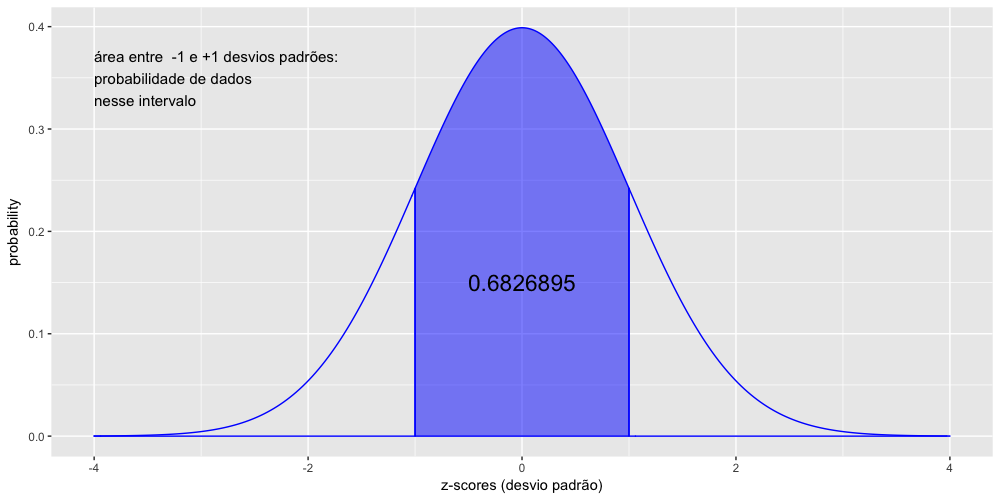

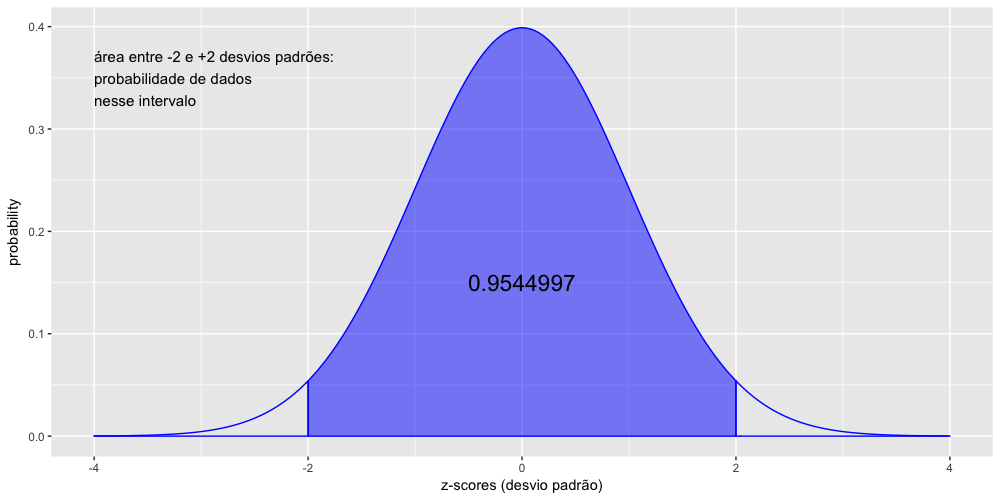

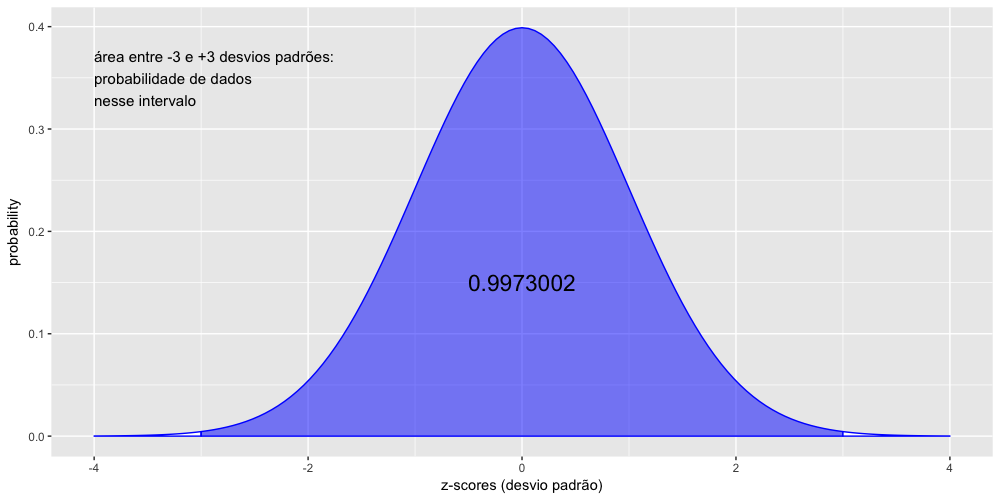

- A curva normal padrão

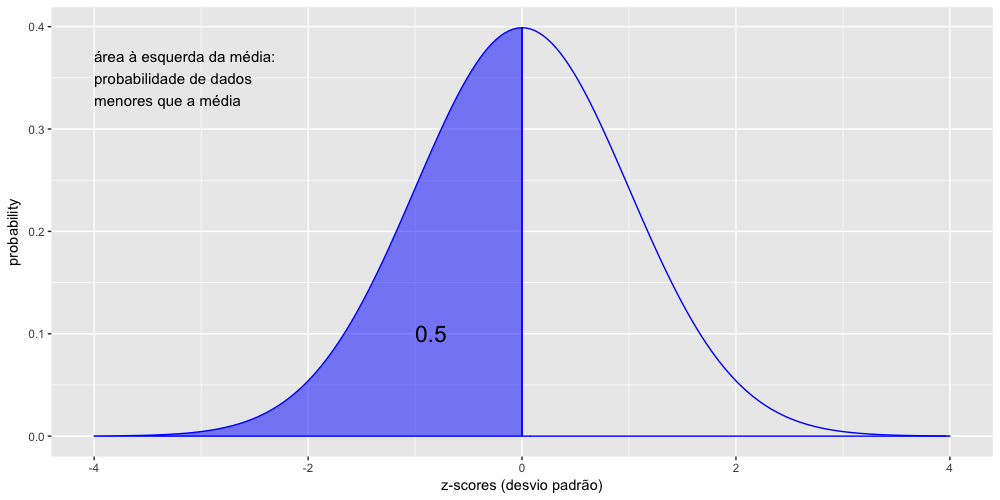

- A normalização e os z-scores.

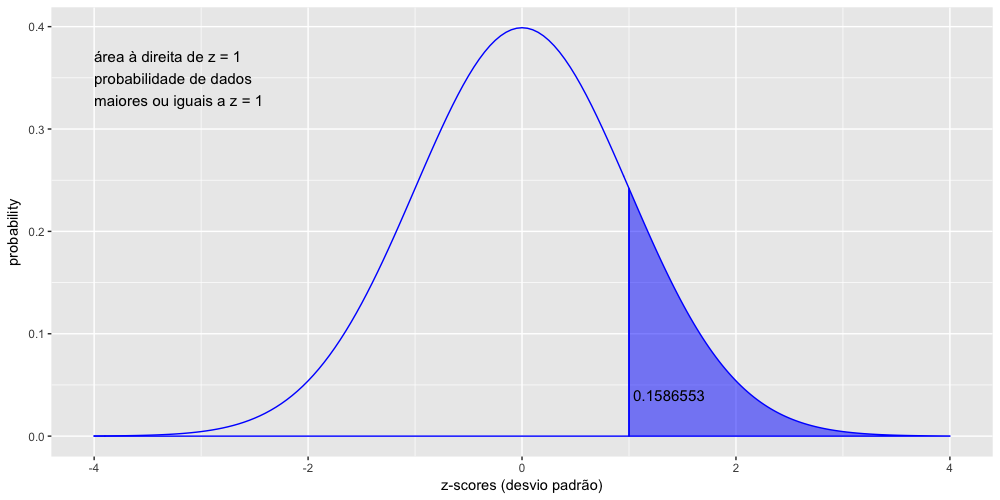

- Calculando as probabilidades - parte 1: pnorm(x)

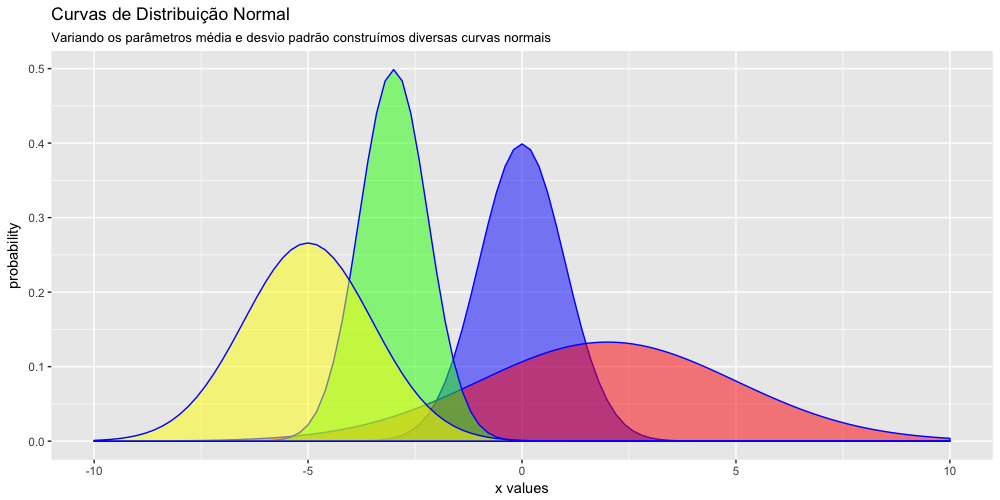

- Os parâmetros da curva normal - média e desvio padrão

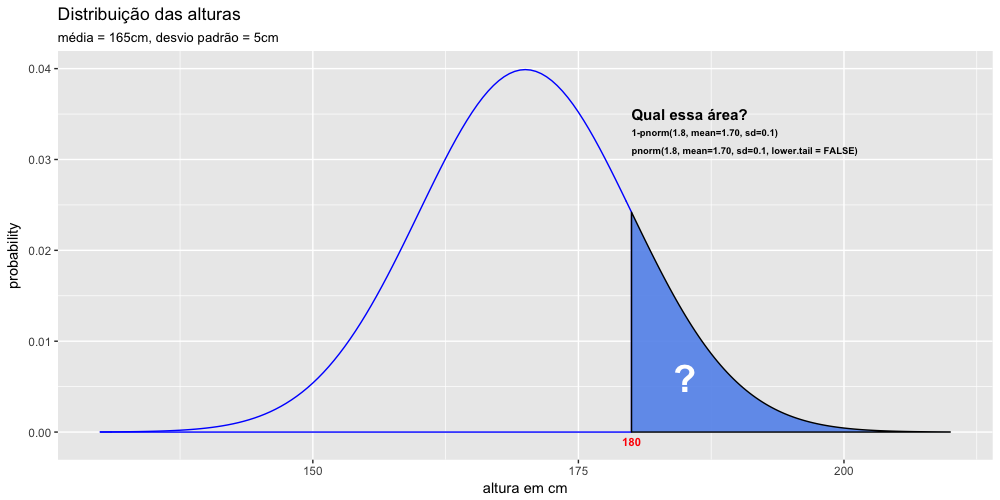

- Calculando as probabilidades - parte 2: pnorm(x, mean= , sd= )

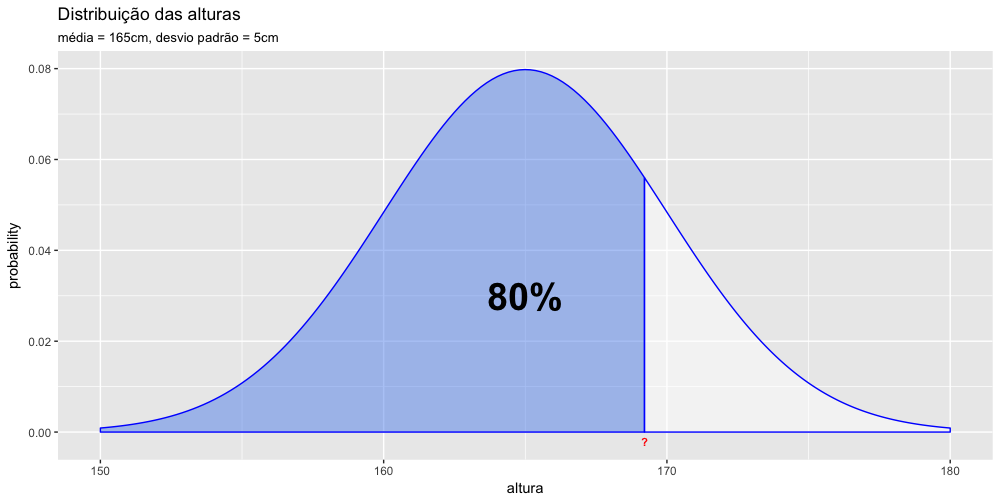

- Calculando probabilidades parte 3 - a função qnorm()

- Simulando uma distribuição normal

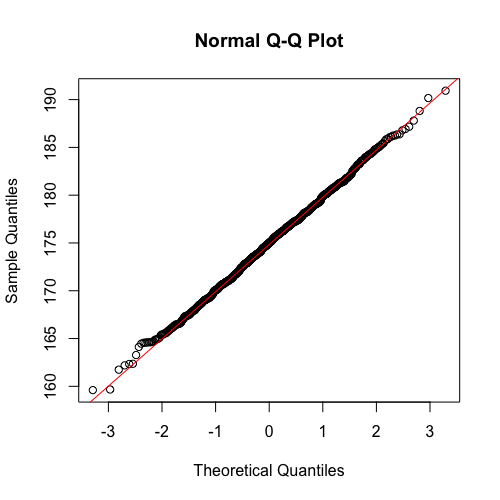

- Verificando a normalidade.

- População e amostra

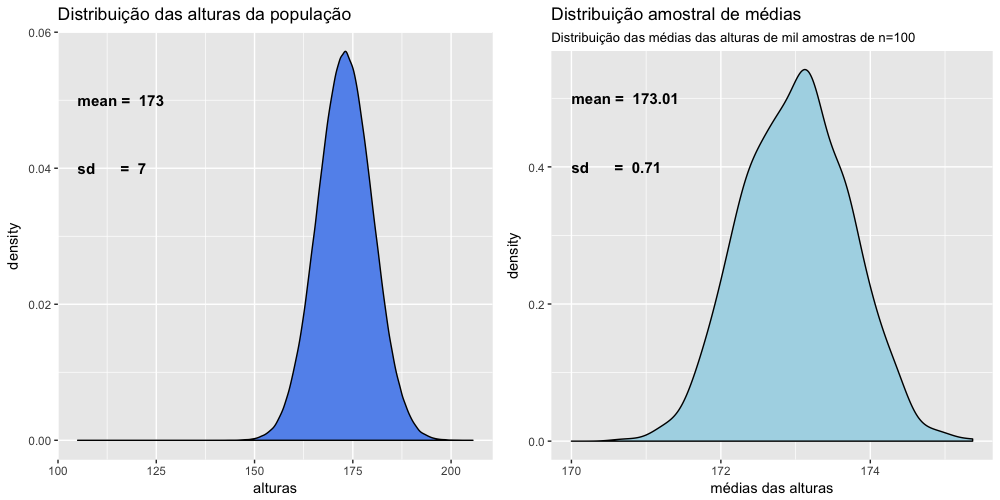

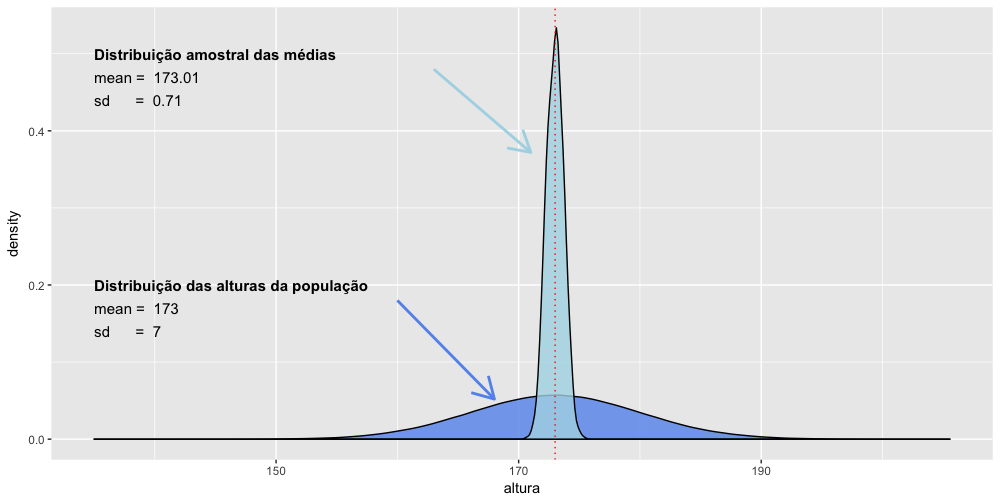

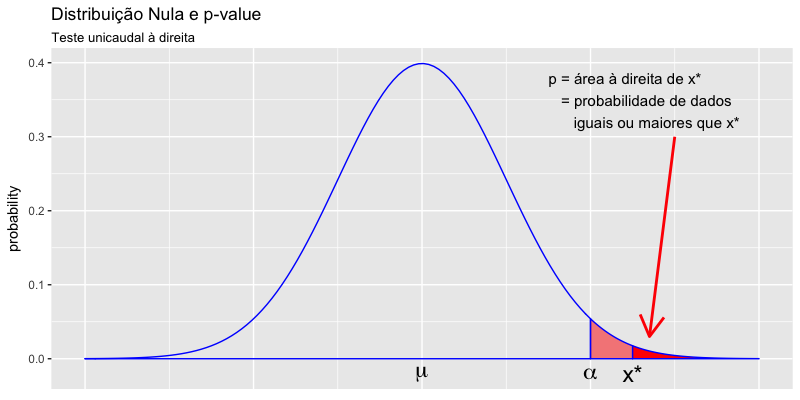

- Distribuição nula

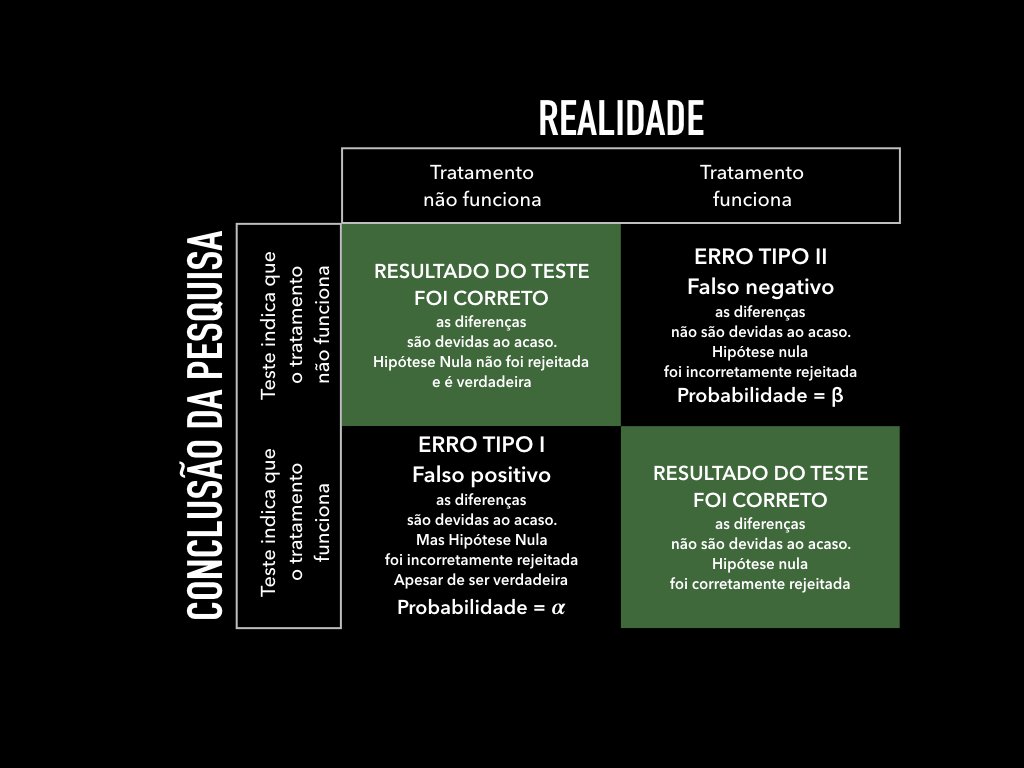

- Teste de Hipóteses

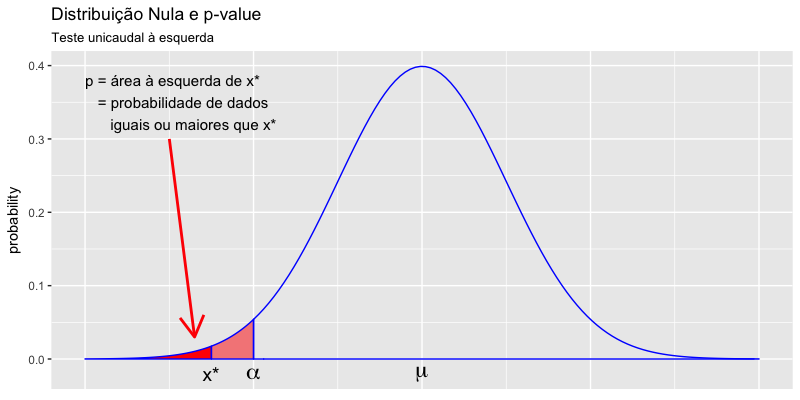

- p-values

- Notes

Dedicatória

À minha esposa Esther

E aos meus filhos Gustavo e Leo

Capa

Photo “Flat Lay Black Coffee” by Ronaldo Arthur Vidal, Published on February 18, 2016 on Unsplash

Prefácio

Introdução

Esse manual foi desenvolvido para ser usado em cursos introdutórios de estatística e análise de dados na área de saúde.

Faz parte de um projeto de incentivo à utilização da linguagem R e do ambiente RStudio como ferramentas nas aulas de estatística em cursos das áreas de saúde, tendo sido desenvolvido com o propósito de auxiliar o aprendizado e o uso desses softwares por estudantes sem nenhuma formação em ciência da computação ou linguagens de programação.

Não se pretende fazer uma imersão profunda na linguagem R e de todas suas potencialidade, pelo contrário, o que esse manual almeja é fazer uma introdução à linguagem R de forma simples e, na medida do possível, agradável, sem sobrecarregar o estudante.

Também não se pretende aqui discutir ou analisar fórmulas estatísticas, mas sim desenvolver os conceitos básicos da análise descritiva e inferencial com o uso da linguagem R.

Esse é um trabalho em construção, ainda em um estágio inicial, sugestões e correções são muito bem vindas.

R - uma linguagem para análise de dados e gráficos

Aprender uma linguagem computacional de estatística pode parecer inicialmente assustador para alunos de graduação da área da saúde. Entretanto, estamos aprendendo novas línguas a todo momento e uma linguagem computacional nada mais é do que uma nova língua.

Todo ramo da ciência tem sua língua própria, muitas vezes incompreensível para quem não foi iniciado naquela disciplina. A medicina tem seu próprio vocabulário, com inúmeros termos obscuros até mesmo para médicos de especialidades diferentes. Todos os ramos do conhecimento têm seu próprio vocabuário e seu modo próprio de fazer a comunicação da informação. A linguagem de sinais tem em seus gestos a forma de expressar a linguagem, a música tem uma notação gráfica para expressar toda suas notas, melodias, ritmos. Até mesmo jogos tem uma linguagem própria. O xadrez tem vários sistemas de notação para expressar os movimentos do jogo.

Não apenas os ramos da ciência têm sua língua, mas também cada equipamento, cada máquina, seja um carro, um microondas, um computador ou um smartphone, tem também sua própria linguagem. Cada aparelho só compreende aquilo que foi projetado para compreender. Uma torradeira só sabe esquentar e a forma de comunicarmos a ela o momento de fazer isso é apertando um botão. Um microondas é capaz de se aquecer de várias formas, dependendo da informação que é inserida em seu painel. Um smartphone consegue fazer uma infinidade de procedimentos, todos dependentes das informação que é inserida na tela pelo seu proprietário. Quanto mais sofisticado um equipamento, mais funções ele pode realizar, maior vocabulário necessário para essa interação.

Mas, então,como pode alguém sem nenhuma formação em engenharia ou computação, conseguir fazer um equipamento tão sofisticado como um smartphone encontrar a localização de uma cidade, mostrar na tela a imagem de uma rua da cidade, traçar uma rota de sua posição até esse local? Conseguimos isso porque a forma como os seres humanos se comunicam com os equipamentos evoluiu de forma impressionante no último século. Há alguns poucos anos era preciso aprender um código morse para transmitir uma informação pelo telégrafo, hoje com um conhecimento muito mais simples podemos nos comunicar com todo o planeta através da internet num smartphone.

Da mesma forma, as linguagem computacionais evoluiram substancialmente desde sua criação. As primeiras linguagems de programação eram tão obscuras que só apenas umas poucos iniciados eram capazes de usar um computador. Mas cada ano surgem novas linguagens, cada vez mais simples de serem usadas. Atualmente, até mesmo crianças se tornam exímias programadoras.

As linguagens computacionais modernas permitem a comunicação entre um ser humano e um computador de uma forma que cada vez mais simples. E a linguagem R é justamente a ponte entre a linguagem da estatística e a linguagem humana. O R foi criado para ser justamente uma uma linguagem para análise de dados e produção de gráficos (IHAKA, 1996). A linguagem R tornou possível executarmos complexos cálculos matemáticos de forma fácil e rápida e criarmos gráficos complexos com simples comandos.

A importância da Estatística na Medicina

A estatística é uma das áreas fundamentais das ciências da saúde. Em um dos primeiros artigos sobre o ensino da estatística para estudantes de medicina, num editorial do British Medical Journal de 1937, Bradford Hill já salientava que para poder ler de forma crítica a literatura científica o médico precisava dominar os conceitos estatísticos (Hill, 1965). Entretanto, o ensino da estatística só se tornou compulsório nas escolas médicas de Londres a partir de 1975 e em muitos países europeus apenas dez anos mais tarde (Altman e Bland, 1991). Nas últimas duas décadas a Organização Mundial de Saúde tem buscado estratégias para melhorar o ensino da estatística para os profissionais de saúde, tendo em vista que essas habilidades são úteis não apenas para aqueles que desejam se tornar pesquisadores, mas para todos que trabalham com a saúde, pois favorecem o pensamento crítico, lógico e científico, facilitando os processos de tomada de decisão, de análise de riscos e de avaliação das evidências científicas (Lwanga et al., 1999). A falta do conhecimento estatístico coloca em risco todo o projeto de uma prática baseada em evidências, cujo ponto fundamental é justamente a capacidade de uma leitura crítica da literatura científica (Sackett e Rosenberg, 1995).

A importância desse conhecimento se torna ainda mais relevante quando levamos em conta a imensa quantidade de erros estatísticos básicos na literatura médica (Altman e Bland, 1991) e baixa qualidade da literatura científica que, infelizmente, é muito menos confiável do que nossa intuição imagina. Em um dos artigos mais citados de 2005, Ioannidis alerta que cerca de metade dos resultados da literatura científica médica não são verdadeiros (Ioannidis, 2005) e, mais recentemente, que a maioria dos estudos clínicos não são úteis (Ioannidis, 2016). Ou seja, não apenas a maioria dos resultados são falsos, como a maioria dos resultados verdadeiros não são úteis (Ioannidis, 2016). O médico, consumidor principal dessa literatura, precisa mais do que nunca saber analisar de forma crítica esses artigos e, para tanto, a formação sólida em métodos estatísticos é de suma importância.

Entretanto, existem barreiras reais ao ensino da estatística para estudantes das áreas da saúde. A mera menção da palavra “estatística” é suficiente para evocar fortes reações emocionais de rejeição na maioria das pessoas (Hill, 1947). Estudantes de medicina muitas vezes preferem evitar disciplinas com conteúdo matemático e, via de regra, os cursos de estatística ou bioestatística não são muito populares entre esses alunos (Altman e Bland, 1991). Além disso, alunos das áreas de saúde usualmente tem dificuldade em perceber a importância dessa disciplina, não veem razão para estudar metodologia da pesquisa científica e não se sentem motivados para aprender os difíceis conceitos matemáticos fundamentais (Clarke et al., 1980; Altman e Bland, 1991). Essas barreiras podem comprometer seriamente o aprendizado da estatística pelos estudantes de medicina e, como resultado disso, fazer com que muitos médicos sejam incapazes de uma leitura crítica da literatura científica.

A performance do aprendizado de um estudante está diretamente relacionada a diversos fatores, tais como o seu grau de engajamento, ao prazer em estudar o conteúdo, ao seu sentimento de confiança na capacidade de aprender, a sua determinação para aprender. Assim, devem ser buscados mecanismos que possibilitem aumentar esses fatores. Um desses fatores é o uso de softwares estatísticos adequados. O uso de um software em cursos introdutórios de estatística deve levar em consideração uma série de fatores: disponibilidade, custo, facilidade de uso, possibilidade de geração de gráficos e imagens, facilidade de acesso a literatura sobre o software, documentação do software, disponibilidades de pacotes auxiliares, utilidade futura do software na vida acadêmica.

A linguagem estatística R associada à interface do RStudio preenchem da melhor forma possível os requisitos necessários para essa função.

Breve História do R

A origem do R é a Linguagem S, que foi desenvolvida por John Chambers em 1976, enquanto trabalhana nos laboratórios da empresa de telefonia AT&T Bell Labs. No início da década de 90, a linguagem S foi incrementada com uma notação para modelos estatísticos, resultado numa significativa economia de esforço de programação para análise estatística de dados. No final da década de 90 o S foi revisado e se tornou uma linguagem de alto padrão totalmente baseada em programação por objetos. Essa é versão atual da linguagem S, que deu origem ao R.

A linguagem R foi criada por volta de 1993 por Robert Gentleman e Ross Ihaka, na universidade de Auckland, na Nova Zelândia, como uma ferramenta para ensino nos cursos introdutórios de estatística desses professores (Ihaka, 98).

O R é o produto de uma colaboração entre estatísticos para criação de um ambiente computacional poderoso, programável, portátil e aberto, aplicável aos problemas mais complexos e sofisticados, bem como análises “rotineiras”, sem restrições de acesso ou uso, executável em diversos sistemas operacionais (macOS, Windows, Linux).

O R é uma linguagem de código aberto e livre, publicado sob a licença pública GNU, mantido pela R Foundation. Sua estrutura de código aberto e de software público e gratuito atraiu um grande número de desenvolvedores.

A popularidade do R tem crescido ininterruptamente, principalmente nos últimos 5 anos (Robinson, 2017). Atualmente o R é um dos principais softwares estatísticos usados em pesquisas acadêmicas, principalmente em pesquisas na área médica, pois o R é “a ferramente de escolha para muitos métodos estatísticos necessários nos estudos clínicos” (Robinson, 2017). O R é atualmente o principal repositório de funções estatísticas validadas (Revolutions, 2017b).

“R has really become the second language for people coming out of grad school now, and there’s an amazing amount of code being written for it,” said Max Kuhn, associate director of nonclinical statistics at Pfizer (Vance, 2009).

Nos últimos anos o uso do R como ferramenta para aulas de estatísticas cresceu muito e surgiram vários pacotes específicos para uso como ferramentas de ensino da estatística, tais como o mosaic, Teachingdemos, simpleR, uwIntroStats. Foram lançados nos últimos anos diversos livros textos introdutórios de estatística baseados no uso do R: Introductory Statistics with R, Discovering Statistics Using R, Learn Statistics Using R, An R Introduction to Statistics, Introduction to probability and Statistics Using R, OpenIntro Statistics e diversos outros manuais introdutórios disponíveis livremente na internet. Em 2014, durante o New England Statistics Symposium, foi lançado o site StatsTeachR, um site open-access, repositório de módulos de ensino da estatística usando o R.

O R possui uma rica documentação, inúmeros tutoriais gratuitos disponíveis na internet, uma grande e crescente comunidade de suporte. Recentes levantamentos têm revelado que o uso do R tem crescido vertiginosamente nas últimas décadas, sendo atualmente o software estatístico com maior projeção de crescimento.

Timeline

- 1993: Research project in Auckland, New Zealand

- 1995: R Released as open-source software

- 1997: R core group formed

- 2000: R 1.0.0 released (February 29)

- 2003: R Foundation founded

- 2004: First international user conference in Vienna

- 2015: R Consortium founded

-

(fonte: http://blog.revolutionanalytics.com/2016/03/16-years-of-r-history.html)

Comprehensive R Archive Network, CRAN.

O CRAN (Comprehensive R Archive Network) é um repositório onde qualquer pessoa pode contribuir com uma extensão para R (chamadas de “pacote” - packages), desde que atenda aos requisitos de qualidade e licenciamento estabelecidos pelos mantenedores do CRAN. Em janeiro de 2017, graças à comunidade extremamente ativa de desenvolvedores que contribuem para o R diariamente, o CRAN atingiu a marca de 10.000 pacotes disponíveis para download (Revolutions, 2017a).

Popularidade do R

O R tem se tornado cada vez mais popular na pesquisa científica. Em 2009 o jornal New York Times publicou uma reportagem acerca da popularidade o R entre os cientistas. Segundo o New York Times, o R tem se tornado a segunda língua dos pesquisadores.

Numa pesquisa realizada em 2015 pela Rexer Analytics Survey o R foi o mais usado entre 1220 cientistas avaliados.

RStudio

RStudio é um Ambiente de Desenvolvimento Integrado (IDE - Integrated Development Enviroment) para uso da linguagem estatística R. Um IDE é um software com ferramentas de apoio ao desenvolvimento do trabalho e facilita incrivelmente trabalhar com o R. O RStudio foi lançado ao público em 2008 e já conta hoje com um grande número de usuários. Atualmente o Rstudio 'é usado pela NASA, Eli Lilly, AstraZeneca, Samsung, Honda, Hyunday, Walmart, Nestle, General Eletric, Santander, Universidade de Oxford, Universidade de Toronto e inúmeras outras instituições.

A versão gratuita do Rstudio é perfeitamente adequada para os usos acadêmicos, tornando totalmente dispensável o uso de softwares pagos e com custo elevado.

Referências.

1. Ross Ihaka.R : Past and Future History.A Draft of a Paper for Interface ’98. Disponível em: https://www.stat.auckland.ac.nz/~ihaka/downloads/Interface98.pdf. Acessado em 07/01/2018.

2. David Robinson. The Impressive Growth of R. October 10, 2017. Stackoverflow Blog. Disponível em: https://stackoverflow.blog/2017/10/10/impressive-growth-r. Acessado em 07/01/2018.

3. Revolutions. CRAN now has 10,000 R packages. Here's how to find the ones you need. Revolutions Analitics Blog. January 27, 2017. Disponível em: http://blog.revolutionanalytics.com/2017/01/cran-10000.html. Acessado em 07/01/2018.

4. Revolutions. R's remarkable growth. October 10, 2017. Disponível em: http://blog.revolutionanalytics.com/2017/10/rs-remarkable-growth.html. Acessado em 07/01/2018.

5. Ashlee Vance.Data Analysts Captivated by R’s Power. New York Times - Business Computing. January 6, 2009. Disponível em: http://www.nytimes.com/2009/01/07/technology/business-computing/07program.html?pagewanted=1. Acessado em: 07/01/2018.

Instalação do R e do RStudio

Instalando o R

O R pode ser baixado para instalação no site do CRAN:

https://cran.r-project.org/index.html

Instalando o RStudio

O RStudio pode ser instalado a partir do site do RStudio:

Video da instalação no Youtube

Há um pequeno video de instalação do R e do RStudio no Mac no link a seguir:

RStudio - primeiros passos

O R é uma linguagem, uma linguagem escrita. Da mesma forma que precisamos de um papel ou um processador de texto para escrevermos uma carta, também precisamos de um meio onde escrever nossos comandos na linguagem R. Qualquer editor de textos simples poderia servir para escrevermos na linguagem R, o TextEdit no Mac. Entretanto, usar um software específico para escrevermos comandos na linguagem R facilita muito o trabalho. O RStudio é justamente isso e muito mais. E um ambiente completo para escrever todo um projeto de análises estatísticas com a linguagem R.

Os Painéis do RStudio

O Painel Console

O console é o painel no qual podemos digitar e executar comando, e onde os resultados também irão ser exibidos.

O Painel Editor

O Editor é o painel no qual serão exibidos os editores de texto do RStudio. No Editor podemos criar arquivos de Script ou de Notebooks (veremos adiantes esses tipos de arquivos).

O Painel Ambiente

O painel Ambiente possui várias abas: Environment, History, Connections.

A primeira, chamada de Enviroment (ambiente), exibe as variáveis e objetos que estão na memória durante uma sessão do RStudio.

A segunda aba, chamada de History, contém a lista de todos os comandos que foram executados pelo R nas últimas sessões.

A terceira aba, Connections, é usada em projetos mais avançados, para mostrar as conexões do RStudio com bancos de dados. Não usaremos essa aba nesse curso.

O Painel Files

O painel Files também possui várias abas: Files, Plots, Packages, Help e Viewer.

A aba Files mostra a pasta atual do R e os arquivos dessa pasta.

A aba Plots mostra os gráficos criados na sessão do R. Essa aba permite tanto a visualização como a exportação dos gráficos no formato de imagem ou pdf.

A aba Packages mostra os pacotes do R que foram instalados e permite a atualização desses pacotes.

A aba Help mostra o arquivo help do R.

A aba Viewer serve para visualização de arquivos da web. Não usaremos essa aba nesse curso.

R Script

No cinema ou no teatro um script é o texto escrito do diálogos dos personagens. Na ciência da computação um script é um texto escrito em alguma linguagem de programação. No nosso caso, R Script é um texto com comandos da linguagem R. Ou seja, em última análise, um script é nada mais que um documento de texto, que pode ser salvo, assim como podemos salvar documentos que escrevemos com o uso de processadores de texto. Tal como salvamos documentos do Word, também podemos salvar os Scripts escritos no RStudio.

Um script contém a sequencia de comandos que desejamos que sejam executados pelo R. Podemos também escrever os comandos diretamente no console, entretanto os comando assim escritos não podem ser salvos. A vantagem de escrever os comandos num documento de texto é justamente poder salvar esse documento para uso posterior. Em computação é usual denominarmos os comandos num documento de texto como nosso código. Em especial, quando esse código está escrito na linguagem R, é usual denominar esses comando de código em R ou simplesmente de R code.

R Notebook

O R Notebook é um documento de texto mais sofisticado que um R Script. Um documento do tipo R Notebook é um misto de texto e códigos. O texto de um R Notebook é escrito no formato mais usado em ciência chamado de Markdown, intercalado com trechos de código (chamados de code chunks). Essa mistura de texto com code chunks proporciona criar documentos com toda nossa análise estatística de forma muito mais simples. Além disso, um R Notebook pode ser gravado em diferentes formatos (word, pdf ou html) o que simplifica os processos de transferência de arquivos entre colaboradores.

Video Aula

Link para video aula de primeiros passos com o RStudio:

Variáveis no R

Objetos no R

“Everything that exists is an object” “Everything that happens is a function”

John Chambers, Creator of the S programming language

O R é uma linguagem de programação de alto nível e como tal, usa do conceito de objetos. As linguagens de programação desse tipo são chamadas de linguagens orientadas a objetos. Essa abstração simplifica muito a programação e torna muito mais fácil resolver problemas complexos. Os objetos mais comuns do R são chamados de variáveis.

Variáveis no R

Uma variável é um objeto que armazena dados, tais como valores numéricos, datas, caracteres, palavras, valores lógicos (veremos isso adiante) etc.

Operador de Atribuição

Para armazenar um dado numa variável usamos um operador especial, denominado de operador de atribuição:

1 <-

O operador de atribuição serve para atribuirmos um dado a um objeto e tem a forma de uma seta para esquerda, formada pelo sinal de menor imediatamente seguida do sinal de menos <-.

Isso forma uma seta, indicando que o resultado da operação será colocado no objeto à esquerda da seta.

1 > x <- 2

2 > y <- 3

3 > z <- "Maria"

Observe que ao criar uma variável para armazenar uma palavra ou um caractere, é necessário colocar essa palavra entre aspas. O R entende que está entre aspas é uma palavra ou um texto e não um número.

Operadores Aritméticos

Os operadores mais comuns do R são os aritméticos:

| operador | ação |

|---|---|

| + | somar |

| - | subtrair |

| / | dividir |

| * | multiplicar |

| ^ | elevar à uma potência |

Veja nos exemplos abaixo algumas operações matemáticas simples:

1 > x <- 2

2 > y <- 3

3 > z <- (x + y)^2

Precedência de Operações

Assim como na matemática, também no R existem regras de precedência de operações com um detalhe: os parênteses sempre tem preferência, ou precedência, sendo usados para colocarmos as operações na ordem desejada. ou seja, as operações entre parênteses tem prioridade sobre outras operações. Veja o exemplo abaixo

1 < 4 * 3 + 2

2 [1] 14

3

4 > (4 * 3) + 2

5 [1] 14

6

7 > 4 * (3 + 2)

8 [1] 20

Comentários no R

Um outro símbolo importante no R é o hashtag #. Esse símbolo indica que o texto a seguir é um comentário, ou seja, é um texto para ser lido por humanos e que o computador simplesmente ignora.

1 # atribuindo o valor de 30 (anos) a variável idade

2 > idade <- 30

3

4 # Calculando a idade em meses e armazenando

5 # esse novo dado na variável idade.meses

6 > idade.meses <- 30 * 12

Estilos de nomeação de variáveis e objetos

Como você deve ter notado, variáveis devem ter nomes fáceis de serem compreendidos, nomes que mostrem o que significam. Se uma variável serve para armazenar a glicemia é mais adequado que essa variável seja denominada glicemia do que apenas x. Por outro lado, devemos usar nomes sucintos e evitar nomes grandes, glicemia é mais apropriado do que niveis.de.glicose.dos.pacientes, que é demasiadamente extenso.

Nomes compostos

Entretanto, quando houver necessidade de usar nomes compostos, o modo adequado é usar um ponto separando as palavras, tais como: glico.fem ou idade.media.

Evite usar o underline em variáveis, a separação de palavras pelo o underline é geralmente usado para nomear arquivos tais como: research_results_fase_1.csv.

Evite usar maiúsculas para separar as palavras de uma variável, pois esse estilo geralmente é usado para nomear funções, tal como em “solveEquation”. Veja que as palavras são separadas pelo uso de uma maiúscula no início das palavras, exceto a primeira. Esse modo criar nomes é geralmente usado para nomearmos funções, portanto, vamos evitar fazer isso ao criarmos nomes de variáveis.

Regras para criação de nomes de objetos

Além dessa dica, existem regras formais para criar nomes de variáveis:

1. O nome de uma variável deve SEMPRE começar com uma letra

2. O nome de uma variável NÃO pode começar com números ou caracteres especiais

3. O nome de uma variável NÃO pode conter espaços

4. O nome de uma variável NÃO pode conter caracteres com acentos gramaticais.

Case Sensitive

Um ponto importante: o R é case sensitive, ou seja, maiúsculas e minúsculas são considerados caracteres diferentes: portanto as variáveis idade e Idade são diferentes. A dica é evitar usar maiúsculas em nomes de variáveis, para não criar confusão.

Vetores no R

Vetores são objetos fundamentais de todas linguagens computacionais. Um vetor é um conjunto de elementos da mesma natureza. Por exemplo, um conjunto de números, um conjunto de palavras, etc.

A forma mais comum de criar um vetor no R é através do uso do comando c que signific acombine, como mostrado a seguir.

1 # criando um vetor numérico com idades dos pacientes

2 > idades <- c(45, 32, 24, 23, 55, 56)

3

4 # criando um vetor com nomes dos pacientes:

5 > nomes <- c("Eduardo", "José", "Antônio", "Pedro", "Maria", "Gustavo")

Tipos de Dados

A ciência depende de dados, que são gerados a partir de alguma forma de coleta. Tudo que for quantificado será armazenado numa variável. Uma variável deve ser entendida como um objeto que contém os resultados dessa coleta de dados.

Mas dados podem ser coletados de difentes modos: algumas dados são provenientes de algo que foi contado, outros dados provém de algo que foi medido. Contar e medir fornecem diferentes tipos de dados. Podemos por exemplo, contar o nº de pessoas com AIDS, o nº de eleitores de um determinado político, o nº de óbitos, de nascimentos etc. Por outro lado, podemos medir o perímetro cefálico de crianças recém-nascidas, o nível pressórico ou de glicemia de um grupo de pacientes, etc.

Variáveis com dados provenientes de contagem são denominadas variáveis categóricas, também chamadas de variáveis qualitativas, pois podem expressar uma qualidade (qual o nº de asiáticos no brasil)

Variáveis com dados provenientes de medidas são denominadas variáveis numéricas, também chamadas de variáveis quantitativas.

As variáveis categóricas (ou qualitativas) se dividem em nominais e ordinais.

As variáveis numéricas por sua vez são tradicionalmente divididas em variáveis numéricas discretas e numéricas contínuas.

A necessidade de classificarmos as variáveis em diferentes tipos é devido ao fato de que o tipo de variável determina os tipos de operações matemáticas que podem ser realizadas e, consequentemente, as medidas estatísticas e os testes estatísticos que podem ser realizados.

Variáveis categóricas (qualitativas)

Algumas variáveis são nomes que expressão uma qualidade (que podem ter ou não uma ordenação). Em estatística essas variáveis são chamadas categóricas e podem se dividir em nominais ou ordinais. Variáveis nominais expressam qualidades, mas sem uma ordenação. Variáveis ordinais também expressão qualidades, mas tem uma ordenação. As variáveis categóricas não podem ser usadas em operações aritiméticas. Não podemos, por exemplo, calcular a média desse tipo de variável. O que podemos fazer com variáveis categóricas é construir tabelas de frequências de cada categoria.

No R as variáveis categóricas são chamados de factor.

Os dados das variáveis que não possuem nenhuma ordenação, são chamadas de variáveis categóricas nominais. Quando uma variável categórica tem uma ordenação ela recebe o nome de variável ordinal. O R não tem nomes distintos para esses dois tipos de variáveis categóricas, sendo ambas classificadas no R como sendo do tipo factor.

Entretanto, é possível indicar para o R que a ordenação de uma variável é importante. A função factor() permite atribuir uma ordem às variáveis nominais, tornando-as assim variáveis ordinais. Isso é feito configurando o parâmetro de ordem para TRUE e atribuindo um vetor com a hierarquia de nível desejada. Sem essa ordenação vamos ter problemas ao fazer gráficos que precisam de uma ordem, pois não controlamos a ordem que será colocada no gráfico.

A linguagem R trabalha com diferentes tipos de variáveis para armazenar as diferentes categorias de dados. As variáveis no R podem ser classificadas como numéricas (para armazenar dados numéricos), caracteres (para armazenar palavras), datas etc. Para verificar o tipo de dado de uma variável ou vetor, basta usar a função class( ). Vejamos alguns exemplos.

1 > nomes <- c("Henris", "Leo", "Gustavo")

2 > class(nomes)

3 [1] "character"

Variáveis quantitativas (numéricas)

As variáveis quantitativas (numéricas) são resultado de alguma medida realizada. Podem ser números inteiros (discretas) ou reais (contínuas). A grande diferença dessas variáveis com as qualitativas é que com as variáveis numéricas podemos fazer todas operações matemáticas: somar, dividir, calcular a média, a variância, o desvio padrão etc.

1 > idade <- c(45,10,12)

2 > class(idade)

3 [1] "numeric"

Variáveis Lógicas

Existem variáveis chamadas de lógicas. Variáveis lógicas armazenam o resultado de uma operação lógica. Operações lógicas são aquelas realizadas através de operadores lógicos: igual, maior, maior ou igual, menor, menor ou igual, etc.

| operador | significado |

|---|---|

| < | menor que .. |

| <= | menor ou igual a … |

| > | maior que … |

| >= | maior ou igual a … |

| == | extamente igual a … |

| ! | não / negação |

| != | não igual ou diferente de … |

| OR | |

| & | AND |

Variáveis lógicas são aquelas que armazenam resultados de operações lógicas. No exemplo uma operação lógica é realizada e seu resultado é colocado numa variável.

1 > resultado.1 <- (4 < 5)

2 > resultado.1

3 [1] TRUE

4

5 > resultado.2 <- (10 < 5)

6 > resultado.2

7 [1] FALSE

Veja que o valor da variável resultado.1 é TRUE, pois quatro é realmente menor que cinco. Da mesma forma o valor da variável resultado.2 é FALSE, pois 10 não é menor que 5.

Usando a função class( ), podemos verificar que as variáveis resultado.1 e resultado.2 são do tipo logical (lógico).

1 > class(resultado.1)

2 [1] "logical"

3

4 > class(resultado.2)

5 [1] "logical"

Um ponto importante a ser memorizado é que é usual em linguagens de programação que TRUE tenha o valor de 1 e FALSE tenha o valor de 0.

portanto:

1 > resultado.1 * 5

2 [1] 5

3

4 > resultado.2 * 5

5 [1] 0

NA Values

É muito frequente que faltem dados em pesquisas. Às vezes uma questão de um questionário deixou de ser respondida, às vezes um dado não foi encontrado etc. Esses dados são representados no R como NA, que significa NOT AVAILABLE. É importante reconhecer a existência desses dados faltantes pois a presença desses dados faltantes pode impedir que sejam executados cálculos matemáticos. Afinal de contas, o que poderia significar 3*NA? Experimente fazer essa conta no R.

Funções no R

As funções são a base de uma linguagem de programação. Assim como uma função matemática, na computação uma função recebe um conjunto de dados, processa esses dados e retorna um resultado.

Uma função y=2x recebe como input um valor e dá como resultado o dobro desse valor.

A função y=sen(x) recebe como input um determinado valor numérico e dá como resultado o seno desse valor.

A linguagem R tem inúmeras funções estatísticas que executam os inúmeros cálculos matemáticos necessários para resolvermos problemas estatísticos, desde os mais básicos até os mais complexos, facilitando bastante o ensino e a aprendizagem da estatística.

Argumentos de uma função

Toda função no R tem a seguinte estrutura: nome(argumentos). Ou seja, o nome da função, entre parênteses, os argumentos da função. Observe que não há espaços entre o nome da função e os parênteses com os argumentos.

Denominam-se argumentos de uma função os dados que são inseridos na função para o cálculo desejado. Vejamos como exemplo função para extrair a raiz quadrada de um número: sqrt().

O nome da função é sqrt, é uma abreviação de square root, ou raiz quadrada. Entre parênteses colocamos os argumentos, nesse caso, o número que desejamos que seja extraída a raiz quadrada. Portanto, para obter a raiz quadrada de 225 basta usar a função sqrt() com o argumento 225:

1 > sqrt(225)

2 [1] 15

Uma função pode ter mais de um argumento, o que é o mais comum na verdade. E alguns argumentos servem para indicar como a função deve se comportar. Uma função fundamental do R é a que lê os arquivos com dados, para que possamos fazer nossos cálculos. Um argumento dessa função é o nome do arquivo, outros argumentos são: se esse arquivo contém cabeçalho, se os dados estão separados por vírgula ou ponto e vírgula, se o decimal é uma vírgula ou um ponto etc. Para usar essa função devemos informar todos esses argumentos.

No exemplo abaixo, mostramos a função read.csv( ) e como essa função pode ser usada para ler um arquivo chamado resultados.csv, que contem cabeçalhos, cujos dados estão separados por vírgulas e cujos valores decimais são separados por um ponto:

1 read.csv(file ="resultados.csv",

2 header = TRUE,

3 sep = ",",

4 dec = ".")

na.rm = TRUE

Um argumento importante de muitas funções é o na.rm = TRUE. a expressão na.rm é uma abreviação de REMOVE NOT AVAILABLE DATA, ou seja, remova os dados faltantes. Ao indicarmos que esse argumento é verdadeiro (TRUE), o R irá desconsiderar dados em branco ou faltantes ao fazer os cálculos. Sem esse argumento, frequentemente os cálculos não são realizados.

Algumas funções matemáticas comuns:

| função | ação |

|---|---|

sqrt() |

calcula a raiz quadrada |

log() |

calcula o logaritmo natural |

abs() |

retorna o valor absoluto |

Algumas funções estatísticas comuns:

| função | ação |

|---|---|

mean() |

calcula a média de um conjunto de valores |

median() |

calcula a mediana de um conjunto de valores |

sum() |

calcula a soma de um conjunto de valores |

min() |

retorna o valo mínimo de um conjunto de valores |

max() |

retorna o valor máximo de um conjunto de valores |

var() |

calcula a variância de um conjunto de valores |

sd() |

calcula o desvio padrão de um conjunto de valores |

Pacotes do R

Uma das maiores forças da linguagem R é o seu excelente conjunto de pacotes (packages). Pacotes são conjuntos de funções criadas por outras pessoas que contribuem para o desenvolvimento da linguagem R. Como o R é uma linguagem aberta, qualquer pessoa pode contribuir criando pacotes. Atualmente o R é um dos mais importantes repositórios de funções estatísticas, sendo muito comum que teses de mestrado na área da estatística se tornem pacotes do R.

Na verdade, uma das principais razões do sucesso do R são os pacotes extremamente versáteis que a linguagem hoje dispõe. O R tem hoje mais de 10.000 pacotes só no site do CRAN, além de milhares de outros em diferentes sites.

Dentre esses tantos pacotes, alguns se destacam pela sua extrema versatilidade e um nome se destaca no universo da estatística: Hadley Wickham, um estatístico neozelandês, é o responsável pela criação dos pacotes mais famosos do R, entre eles o ggplot2 para geração de gráficos é o dplyr para manipulação de dados.

O pacote ggplot2 é o pacote gráfico mais importante do R, já tendo sido baixado mais de 10 milhões de vezes do site do CRAN. O código abaixo mostra o total de downloads do ggplot2:

1 library(tidyverse)

2 library(dlstats)

3 stat.ggplot <- cran_stats(c("ggplot2"))

4 downloads.gg <- stat.ggplot %<%

5 select(downloads) %<%

6 sum

O pacote dplyr, por sua vez, já foi baixado mais de 6 milhões de vezes do site do CRAN, sendo um dos pacotes mais usados para manipulação de dados.

Esses dois pacotes e vários outros podem ser instalados mais facilmente através da instalação do pacote tidyverse. O tidyverse é uma coleção de pacotes, instalando automaticamente uma série de pacotes úteis em análises de dados, entres eles o dplyr, ggplot2 e outros, sendo o modo mais prático de instalar esses pacotes, pois com um único comando são instalados diversos pacotes. Mais informações sobre o pacote tidyverse podem ser encontradas em https://www.tidyverse.org.

Para instalar um pacote, você pode usar a função install.packages() no console. É importante salientar que um pacote deve ser sempre instalado a partir do console e nunca a partir de um script ou de qualquer outro documento de texto. Além disso, vale a pena lembrar que um pacote só precisa ser instalado uma única vez. Por outro lado, sempre que desejamos usar o pacote precisamos carregar esse pacote na memória (na sessão do R) com o comando library(). Esse carregamento do pacote na sessão deve ser feito toda vez que formos usar o pacote, de preferência no início da sessão. Em geral o comando library( ) deve ser um dos primeiros comandos de um script.

Por exemplo, para instalar o pacote tidyverse usamos o comando install.packages() no console, como mostrado abaixo:

1 > install.packages("tidyverse")

Observe que o comando install.packages() exige que o nome do pacote a ser instalado esteja entre aspas.

Ao executar esse comando você verá que o R instala diversos pacotes.

Para carregar o pacote tidyverse em sua sessão R atual, use o comando library() no início de seu script ou de seu R Notebook, como mostrado abaixo.

1 library(tidyverse)

Observe que no comando library() o nome do pacote não precisa ser escrito entre aspas.

Data Frames

Data frames são as estruturas de dados mais importantes do R e uma das principais razões do uso crescente da linguagem R. Superficialmente um data frame é como uma planilha do Excel, com colunas e linhas.

Cada coluna de um data frame é uma variável, ou melhor, um vetor.

Cada linha de um data frame é uma observação.

Por exemplo, numa pesquisa com 50 pacientes, na qual são coletados dados de nome, idade, sexo, estado civil, profissão e diagnóstico, nosso data frame consistiria de 50 linhas (cada linha para um paciente) e 6 colunas (nome, idade, sexo, estado civil, profissão e diagnóstico).

Um modo de criar um data frame é com a função data.frame(), como a seguir:

1 > nome <- c("Henrique", "Antônio", "Fabiano")

2 > idade <- c(45, 40, 48)

3 > mydata <- data.frame(nome, idade)

A última linha acima criou o data frame, com as colunas nome e idade e com 3 linhas, uma para cada paciente.

O Operador $

O operador $ é usado para acessarmos as colunas de um data frame. Para acessarmos a coluna com as idades basta usarmos mydata$idade, como abaixo:

1 > mydata$idade

2 [1] 45 40 48

Para calcular a média das idades dos pacientes no data frame acima basta usar a função mean, colocando mydata$idade como argumento da função, como abaixo:

1 > mean(mydata$idade)

2 [1] 44.33333

Datasets do R

O R possui vários datasets (conjuntos de dados) para facilitar o aprendizado. Para saber mais sobre os datasets inclusos no R digite no console o comando abaixo:

1 > data( )

Podemos carregar os datasets já inclusos no R com a função mesma função data( ), mas incluindo como argumento o nome do dataset desejado. No exemplo a seguir iremos carregar o dataset USArrests. Este dataset contém estatísticas das prisões por 100.000 habitantes por assalto, assassinato e estupro em cada um dos 50 estados dos EUA em 1973, como também a porcentagem da população urbana.

1 > data("USArrests")

Como esse dataset carregado podemos agora visualizar os dados simplesmente digitando o nome do dataset no console

1 > USArrests

Experimente também usar a função str(), que mostra a estrutura dos dados de um objeto, para verificar a estrutura e o tipo de objeto é esse dataset:

1 > str(USArrests)

Você deverá obter como resultado que o dataset USArrests é um data frame com 50 observações (50 linhas) e 4 variáveis (Murder, Assalt, UrbanPop e Rape), como mostrado abaixo:

1 'data.frame': 50 obs. of 4 variables:

2 $ Murder : num 13.2 10 8.1 8.8 9 7.9 3.3 5.9 15.4 17.4 ...

3 $ Assault : int 236 263 294 190 276 204 110 238 335 211 ...

4 $ UrbanPop: int 58 48 80 50 91 78 77 72 80 60 ...

5 $ Rape : num 21.2 44.5 31 19.5 40.6 38.7 11.1 15.8 31.9 25.8 ...

Observe que antes de cada variável se encontra o operador $, que é o modo de acessar cada uma dessas variáveis. Experimente digitar o comando abaixo para acessar a variável Murder:

1 > USArrests$Murder

Datasets externos

Os datasets inclusos no R servem apenas para treinamento do uso. O mais importante numa análise estatística é poder usar seu próprio conjunto de dados, proveniente de sua pesquisa. Para isso é necessário ler um arquivo externo e carregar esse arquivo na sessão do R. O RStudio possui uma função para importação de arquivos dentro da aba File -> Import Dataset. Entretanto, devemos SEMPRE EVITAR importar arquivos por esse meio. O método mais indicado para importar um arquivo é fazer isso dentro do próprio Script, usando as funções de leitura de dados como mostrado no próximo capítulo.

Lendo Dados

Para podermos efetivamente usar o R, uma etapa inicial é justamente carregarmos os dados a serem analisados. Existem diversos formatos de arquivos para armazenar dados, cada um apropriado para ser lido por determinados aplicativos. Vejamos:

| formato | Tipo de dados | software para ler os dados |

|---|---|---|

| .txt | texto | Qualquer leitor de texto |

| .doc | texto | Word (microsoft) |

| .docx | texto | Word (microsoft) |

| .xls | planilha | Excel (microsoft) |

| .ppt | slides | PowerPoint (microsoft) |

| documento portátil | Qualquer leitor de PDF (ex: Acrobat) | |

| .pages | texto | Pages (Apple) |

| .numbers | planilha | Numbers (Apple) |

| .key | slides | Keynote (Apple) |

| .csv | dados | Qualquer leitor de texto |

Alguns formatos de arquivos dependem de um software específico para sua leitura. Outros formatos são menos expecíficos, podendo ser lidos por um grande número de softwares, como é o caso dos arquivos .txte dos arquivos .pdf. Esses formatos são mais universais, sendo padrões comuns para comunicação de informações textuais.

Quando essa troca de dados se refere não um texto propriamente dito, mas um conjunto de dados, tais como tabelas com dados, um dos formatos mais universais é o .csv (comma separated values = valores separados por virgulas).

A estrutura desse arquivo é bastante simples: existem várias linhas, cada linha com vários dados, separados por vírgulas. Existem, entretanto variações nesse formato, por exemplo, no Brasil as casas decimais são separadas por vírgulas, nesse caso o delimitador dos valores não poderia ser a vírgula e é usado então o ponto e vírgula. Ao ler dados no formato .csv é sempre importante informar se os dados são separados por , ou ; e se o separador do decimal é a virgula , ou o ponto final .. Caso contrário a leitura dos dados poderá ser corrompida.

Para ler dados no R o ideal é que os dados estejam, de preferência, no formato separado por vírgulas, chamado de “comma separated values” ou, simplesmente de csv. A extensão .csv no final do nome de um arquivo indica que esse é um arquivo de dados no formato separado por vírgulas. Todo software de planilhas, tal como o Excel ou Numbers (do Mac) são capazes de salvar os dados nesse formato.

O R tem uma função especial para ler esses tipos de dados: read.csv( ).

Os argumentos dessa função já foram mostrados no capítulo sobre as funções:

| argumentos | valor default | valor que necessita ser ajustado |

|---|---|---|

file = |

não possui | “nome do arquivo a ser lido.csv” |

na.strings |

NA | trocar para o que estiver sendo usado no arquivo |

header |

FALSE |

trocar para TRUE se houver cabeçalho no arquivo |

sep |

espaço | trocar para "," ou ";" conforme o usado no arquivo |

dec |

”.” | usar o default ou trocar por "," se for o caso |

O código de exemplo abaixo lê um arquivo de dados chamado pesquisa.csv, no formato .csv, no qual há há um cabeçalho (header= TRUE) , cujos valores estão separadads por vírgula (sep = ",") e o separador decimal é o ponto final (dec = ".")

1 read.csv(file = "pesquisa.csv",

2 header = TRUE,

3 sep = ",",

4 dec = ".")

Argumentos default

Caso o arquivo esteja no formato .csv com as especificações acima, podemos usar essa mesma função informando apenas o nome do arquivo, pois a função read.csv() assume como valores default essas especificações, bastando indicar o nome do arquivo: a função read.csv().

1 read.csv(file = "pesquisa.csv")

Ou seja, com os dados no formato padrão, a leitura dos dados é extremamente fácil com o comando acima. Esse comando lê o arquivo chamado pesquisa.csv. Mas falta ainda um detalhe: é preciso colocar os dados lidos numa variável. O comando correto deve ser parecido com a linha abaixo. É lógico que você pode mudar o nome da variável que vai receber os dados. No caso abaixo a variável, ou melhor, o objeto, que vai receber os dados foi chamado de mydata e os dados estão sendo lidos de um arquivo chamado pesquisa.csv.

1 mydata <- read.csv(file = "pesquisa.csv")

Agora sim, os dados são lidos e colocados na variável mydata. Você verá que, ao ler um arquivo de dados dessa forma, o objeto mydata será um data frame, com linhas representado cada paciente (observação) e colunas representando as variáveis da pesquisa.

RStudio Projects

Working Directory

Toda sessão de trabalho com R tem uma diretório de trabalho associado. Para que o R possa ler um arquivo, é necessário que esse arquivo esteja na pasta do diretório de trabalho da sessão do R. Se o arquivo a ser lido estiver em outra pasta, será invisível para o RStudio.

Podemos indicar ao R que diretório da sessão de trabalho seja o diretório da aba Files. Para isso, clique em Session (no menu do RStudio) e em seguida em

Set Working Directory -> To Files Pane Location.

Entretanto, esse é um método muito arcaico e desajeitado e trabalhoso para fazer toda vez que formos usar o RStudio.

A melhor forma de resolver esse problema é usar sempre um Project do RStudio.

Projects do RStudio

Um trabalho de análises estatísticas geralmente depende de um arquivo com os dados a serem lidos, de arquivos de R Scripts ou R Notebooks, com os códigos da análise culminando na geração de arquivos de resultados, tais como pdfs ou imanes para serem salvos. O ideal é que todos esses arquivos estejam numa mesma pasta no computador.

O RStudio possibilita a criação de um Project, que torna uma pasta no computador o diretório de trabalho de uma sessão do R sempre que esse Project for aberto.

Quando um Project é aberto, o RStudio cria uma nova sessão de trabalho e define que a pasta do Projeto se torne o diretório de trabalho do R, automatizando o processo de definição do diretório de trabalho e ajudando a organizar a sessão do R.

Criando um Projeto

Antes de criar um projeto, crie primeiro a pasta que servirá de diretório de trabalho em seu computador e salve nessa pasta os arquivos com os dados a serem analisados.

Para criar um projeto (project) clique em Project (na parte superior à direta do RStudio) e em seguida em New Project. A seguir, escolha a opção

Existing Directory - Associate a project with an existing directory.

E, em seguida, clique em Browse para encontrar a pasta existente e associá-la ao seu projeto. Finalmente, clique em Create Project para finalizar o processo de criação de seu projeto.

Video de Criação de Projetos no RStudio

Estatística Descritiva no R

Introdução

Veremos nesse capítulo as medidas mais importantes para descrever uma conjunto de dados: as medidas de localização central (média e mediana) e as medidas de dispersão (variância e desvio padrão). Essas medidas, hoje tão comuns e simples, tiveram um lento e complexo desenvolvimento ao longo de muitos séculos. A noção de que a média poderia representar os dados só surgiu com os trablahos de Galileu por volta de 1632 (Sthal, 2006 ) e o termo desvio padrão só foi cunhado em 1892 pelo estatístico Karl Person (Magnello, 1996). Essas medidas são os blocos fundamentais da estatística moderna e é imprescindível saber usá-las e interpretá-las adequadamente.

Parte 1 - Carregamento do dataset mpg

Para experimentarmos usar as diversas funções estatísticas do R, vamos primeiro carregar um conjunto de dados que vem junto com o pacote ggplot2. Se você já instalou o pacote tidyverse então o ggplot2 já foi instalado. Você pode também instalar o pacote ggplot2 isoladamente se desejar. O comando para instalar os pacotes é o install.packages(). Lembre-se de que a instalação de um pacote deve ser sempre feita no console e nunca num R script ou num R Notebook.

Para instalar o pacote tidyverse, use o comando abaixo no console: (recomendado)

1 > install.packages("tidyverse")

Caso prefira, instalar oggplot2 isoladamente, use o comando abaixo no console:

1 > install.packages("ggplot2")

ATENÇÃO: Se você já instalou esses pacotes, não é necessário instalar novamente.

Com os pacote ggplot2 instalado podemos agora usar os datasets que vem junto com esse pacote. para isso é necessário primeiro carregar o pacote ggplot2 na memória do computador, o que é feito com a função library(ggplot2).

Atenção: observe que ao usar a função library() não precisamos usar as aspas.

Com o pacote ggplot2 estão carregados na memória e podemos usar os datasets que vem junto com esse pacote. Vamos usar o dataset mpg para nosso treinamento de estatística descritiva no R. O acrônimo mpg significa Miles Per Gallon - uma medida de quantas milhas um carro pode viajar se você colocar apenas um galão de gasolina ou diesel em seu tanque (1 galão equivale a 3.79 litros e uma milha equivale a 1.6km).

Esta medida padronizada serve comparar carros com base na sua eficiência. O conjunto de dados mpg que vem junto com o ggplot2 é apenas um subconjunto dos dados de economia de combustível que a EPA (Enviroment Protection Agency - USA) disponibiliza em http://fueleconomy.gov. O conjunto completo dos dados podem ser obtidos nesse site, no link seguir:

http://fueleconomy.gov/feg/download.shtml.

Em primeiro lugar, abra um novo Script para deixar todos os comandos gravados. Escolha um nome para seu Script e salve regularmente esse Script para não perder os dados. Digite os comandos a seguir em seu Script e não no console. Para executar um comando do Script coloque o cursor no final da linha de comandos e clique em Command+Return (no mac) ou Control+Return (no Windows).

No início de seu Script é que você deve colocar os comandos library, como a seguir:

1 library(tidyverse)

Para facilitar essa aula, vamos usar simplesmente o dataset mpg que já vem com o ggplot2. Para carregar esse dataset basta usar o comando abaixo:

1 data(mpg)

Com a função class() podemos verificar que esse dataset é um data frame do R.

1 > class(mpg)

2 [1] "tbl_df" "tbl" "data.frame"

Em primeiro lugar, vamos visualizar as primeiras linhas desse dataset com a função head():

1 > head(mpg)

2

3 # A tibble: 6 x 11

4 manufacturer model displ year cyl trans drv cty hwy fl class

5 <chr> <chr> <dbl> <int> <int> <chr> <chr> <int> <int> <chr> <chr>

6 1 audi a4 1.8 1999 4 auto(l5) f 18 29 p compact

7 2 audi a4 1.8 1999 4 manual(m5) f 21 29 p compact

8 3 audi a4 2.0 2008 4 manual(m6) f 20 31 p compact

9 4 audi a4 2.0 2008 4 auto(av) f 21 30 p compact

10 5 audi a4 2.8 1999 6 auto(l5) f 16 26 p compact

11 6 audi a4 2.8 1999 6 manual(m5) f 18 26 p compact

Com esse comando você pode visualizar as primeiras linhas tabela do dataset mpg.

Podemos também usar o comando str() para visualizarmos a estrutura desse data frame, as variáveis e seus tipos:

1 > str(mpg)

2

3 Classes ‘tbl_df’, ‘tbl’ and 'data.frame': 234 obs. of 11 variables:

4 $ manufacturer: chr "audi" "audi" "audi" "audi" ...

5 $ model : chr "a4" "a4" "a4" "a4" ...

6 $ displ : num 1.8 1.8 2 2 2.8 2.8 3.1 1.8 1.8 2 ...

7 $ year : int 1999 1999 2008 2008 1999 1999 2008 1999 1999 2008 ...

8 $ cyl : int 4 4 4 4 6 6 6 4 4 4 ...

9 $ trans : chr "auto(l5)" "manual(m5)" "manual(m6)" "auto(av)" ...

10 $ drv : chr "f" "f" "f" "f" ...

11 $ cty : int 18 21 20 21 16 18 18 18 16 20 ...

12 $ hwy : int 29 29 31 30 26 26 27 26 25 28 ...

13 $ fl : chr "p" "p" "p" "p" ...

14 $ class : chr "compact" "compact" "compact" "compact" ...

Esse dataset possui 243 linhas (observações) com 11 variáveis. O significado de cada variável está descrito na documentação de ajuda do dataset mpg e pode ser visualizado com o comando ?mpg no console. A tabela abaixo mostra o significado de cada variável:

| variável | significado |

|---|---|

| manufacturer | marca |

| model | modelo |

| displ | cilindradas (Engine Displacement) |

| year | ano de fabricação |

| cyl | número de cilindros |

| trans | tipo de marcha: automática / manual |

| drv | tração: f=frontal, r=traseira, 4=4x4 |

| cty | milhas por galão na cidade |

| hwy | milhas por galão na estrada |

| fl | tipo de combustível: r=regular, p=premium, d=diesel, e=ethanol, c=CNG (gás) |

| class | tipo de carro |

Parte 2 - Tabelas de frequências

Em estatística, uma distribuição de frequências é uma tabela ou gráfico que mostra a frequência das variáveis categóricas (nominais ou ordinais) de uma amostra, ou sejam, o número de ocorrências dessas variáveis. Variáveis numéricas podem também ser mostradas em tabelas de frequencias, nesse caso, é necessário classificar as variáveis numéricas em intervalos. Cada entrada na tabela contém a frequência ou a contagem de ocorrências dentro de um grupo ou intervalo específico. Ou seja, uma tabela de frequências resume a distribuição dos valores da amostra.

Use a função table() para criar tabelas de frequências das variáveis categóricas dessa pesquisa (marca, ano, número de cilindros, tipo de marcha, tipo de combustível, tipo de carro). A função table() mostra as frequencias absolutas de cada uma das classes da variável. Por exemplo, para saber quantos carros nessa amostra tem 4 cilindros, quantos tem 5 cilindros, quantos tem 6 cilindros e quantos tem 8 cilindros podemos usar a função table(), inserindo como argumento a variável cyl, como mostrado abaixo:

1 > table(mpg$cyl)

2

3 4 5 6 8

4 81 4 79 70

Essa tabela pode ficar mais compreensível se nomearmos o conjunto de dados. Nesse caso, a variável cylrepresenta o nº de cilindros dos carros, logo:

1 > table(cilindros=mpg$cyl)

2

3 cilindros

4 4 5 6 8

5 81 4 79 70

Podemos também verificar as proporções relativas de cada variável com a função prop.table().

1 > prop.table(table(cilindros=mpg$cyl))

2

3 cilindros

4 4 5 6 8

5 0.34615385 0.01709402 0.33760684 0.29914530

Caso se deseje expressar as proporções em percentuais, basta multiplicar a tabela por 100

1 > prop.table(table(cilindros=mpg$cyl))*100

2

3 cilindros

4 4 5 6 8

5 34.615385 1.709402 33.760684 29.914530

E para arrendar as casas decimais, usamos a função round(). Veja no exemplo abaixo o uso dessa função arrendondando o percentual para 2 casas decimais.

1 > round(prop.table(table(cilindros=mpg$cyl))*100,2)

2

3 cilindros

4 4 5 6 8

5 34.62 1.71 33.76 29.91

Podemos também usar a função table() para construir tabelas de duas ou mais dimensões. Para isso basta incluir as outras variáveis como argumentos da função. Lembre-se que nomear as variáveis pode tornar a tabela mais compreensível.

1 > table(montadora=mpg$manufacturer, cilindros=mpg$cyl)

2

3 cilindros

4 montadora 4 5 6 8

5 audi 8 0 9 1

6 chevrolet 2 0 3 14

7 dodge 1 0 15 21

8 ford 0 0 10 15

9 honda 9 0 0 0

10 hyundai 8 0 6 0

11 jeep 0 0 3 5

12 land rover 0 0 0 4

13 lincoln 0 0 0 3

14 mercury 0 0 2 2

15 nissan 4 0 8 1

16 pontiac 0 0 4 1

17 subaru 14 0 0 0

18 toyota 18 0 13 3

19 volkswagen 17 4 6 0

Nesse caso, a primeira variável será colocadas nas linhas e a segunda variável será colocadas nas colunas da tabela.

Quando temos tabelas de frequências de duas dimensões, podemos extrair as frequencias relativas tanto por linhas como por colunas, para isso basta inserir mais um argumento na função prop.table():

1 - para calcular as frequencias relativas em cada linha

2 - para calcular as frequencias relativas em cada coluna

1 # frequencias relativas calculadas em cada linha

2 > prop.table(table(montadora=mpg$manufacturer, cilindros=mpg$cyl),1)

3

4 cilindros

5 montadora 4 5 6 8

6 audi 0.44444444 0.00000000 0.50000000 0.05555556

7 chevrolet 0.10526316 0.00000000 0.15789474 0.73684211

8 dodge 0.02702703 0.00000000 0.40540541 0.56756757

9 ford 0.00000000 0.00000000 0.40000000 0.60000000

10 honda 1.00000000 0.00000000 0.00000000 0.00000000

11 hyundai 0.57142857 0.00000000 0.42857143 0.00000000

12 jeep 0.00000000 0.00000000 0.37500000 0.62500000

13 land rover 0.00000000 0.00000000 0.00000000 1.00000000

14 lincoln 0.00000000 0.00000000 0.00000000 1.00000000

15 mercury 0.00000000 0.00000000 0.50000000 0.50000000

16 nissan 0.30769231 0.00000000 0.61538462 0.07692308

17 pontiac 0.00000000 0.00000000 0.80000000 0.20000000

18 subaru 1.00000000 0.00000000 0.00000000 0.00000000

19 toyota 0.52941176 0.00000000 0.38235294 0.08823529

20 volkswagen 0.62962963 0.14814815 0.22222222 0.00000000

Mais uma vez, podemos usar a função round para arrendondar os dados. Nesse caso, para facilitar a compreensão do código, podemos fazer cada etapa separadamente, como abaixo:

1 # criando uma tabela 2x2 com montadoras x nº de cilindros - frequencias absolutas

2 > tabela.1 <- table(montadora=mpg$manufacturer, cilindros=mpg$cyl)

3 > tabela.1

4

5 cilindros

6 montadora 4 5 6 8

7 audi 8 0 9 1

8 chevrolet 2 0 3 14

9 dodge 1 0 15 21

10 ford 0 0 10 15

11 honda 9 0 0 0

12 hyundai 8 0 6 0

13 jeep 0 0 3 5

14 land rover 0 0 0 4

15 lincoln 0 0 0 3

16 mercury 0 0 2 2

17 nissan 4 0 8 1

18 pontiac 0 0 4 1

19 subaru 14 0 0 0

20 toyota 18 0 13 3

21 volkswagen 17 4 6 0

1 # calculandoas frequencias relativas NAS LINHAS, em percentuais da tabela recém cria\

2 da

3 > tabela.2 <- prop.table(tabela.1,1)*100

4 > tabela.2

5

6 cilindros

7 montadora 4 5 6 8

8 audi 44.444444 0.000000 50.000000 5.555556

9 chevrolet 10.526316 0.000000 15.789474 73.684211

10 dodge 2.702703 0.000000 40.540541 56.756757

11 ford 0.000000 0.000000 40.000000 60.000000

12 honda 100.000000 0.000000 0.000000 0.000000

13 hyundai 57.142857 0.000000 42.857143 0.000000

14 jeep 0.000000 0.000000 37.500000 62.500000

15 land rover 0.000000 0.000000 0.000000 100.000000

16 lincoln 0.000000 0.000000 0.000000 100.000000

17 mercury 0.000000 0.000000 50.000000 50.000000

18 nissan 30.769231 0.000000 61.538462 7.692308

19 pontiac 0.000000 0.000000 80.000000 20.000000

20 subaru 100.000000 0.000000 0.000000 0.000000

21 toyota 52.941176 0.000000 38.235294 8.823529

22 volkswagen 62.962963 14.814815 22.222222 0.000000

1 # observe que a soma de cada linha deverá ser 100

2 # arredondando os valores para 1 casa decimal.

3 > tabela.3 <- round(tabela.2,1)

4 > tabela.3

5

6 cilindros

7 montadora 4 5 6 8

8 audi 44.4 0.0 50.0 5.6

9 chevrolet 10.5 0.0 15.8 73.7

10 dodge 2.7 0.0 40.5 56.8

11 ford 0.0 0.0 40.0 60.0

12 honda 100.0 0.0 0.0 0.0

13 hyundai 57.1 0.0 42.9 0.0

14 jeep 0.0 0.0 37.5 62.5

15 land rover 0.0 0.0 0.0 100.0

16 lincoln 0.0 0.0 0.0 100.0

17 mercury 0.0 0.0 50.0 50.0

18 nissan 30.8 0.0 61.5 7.7

19 pontiac 0.0 0.0 80.0 20.0

20 subaru 100.0 0.0 0.0 0.0

21 toyota 52.9 0.0 38.2 8.8

22 volkswagen 63.0 14.8 22.2 0.0

Variáveis cagtegóricas são usualmente resumidas com tabelas de frequências como fizemos acima. Variáveis numéricas podem se resumidas em tabelas, desde que seus valores sejam categorizados em classes ou intervalos. Entretanto, no caso de variáveis numéricas, podemos resumir os dados de outras formas, usando medidas numéricas de centralidade e de dispersão desses dados, como veremos a seguir.

Parte 3 - Medidas de Tendência Central

Média e Mediana

A medida mais frequentemente investigada num conjunto de dados é seu centro, ou o ponto no qual as observações tendem a se concentrar. Medidas de tendência central são as estatísticas que descrevem um conjunto de dados pela sua posição central.

Existem várias medidas (estatísticas) que identificam a posição central de um conjunto de dados. As principais estatísticas que resumem um conjunto de dados pela posição central são a média, a mediana e a moda. A média e a mediana são facilmente calculadas no R através das funções mean() e median().

Vamos avaliar a média e a mediana do consumo dos carros na cidade e na estrada, lembrando que esses dados estão na variável cty e hwydo dataset mpg. Lembre-se que para acessar uma variável de um data frame usamos o operador $ da seguinte maneira: nome.do.data.frame$nome.da.variável.

Calculando a média e a mediana do número de milhas percorridas na cidade por galão :

1 > mean(mpg$cty)

2 [1] 16.85897

3

4 > median(mpg$cty)

5 [1] 17

Calculando a média e a mediana do número de milhas percorridas na estrada por galão :

1 > mean(mpg$hwy)

2 [1] 23.44017

3

4 > median(mpg$hwy)

5 [1] 24

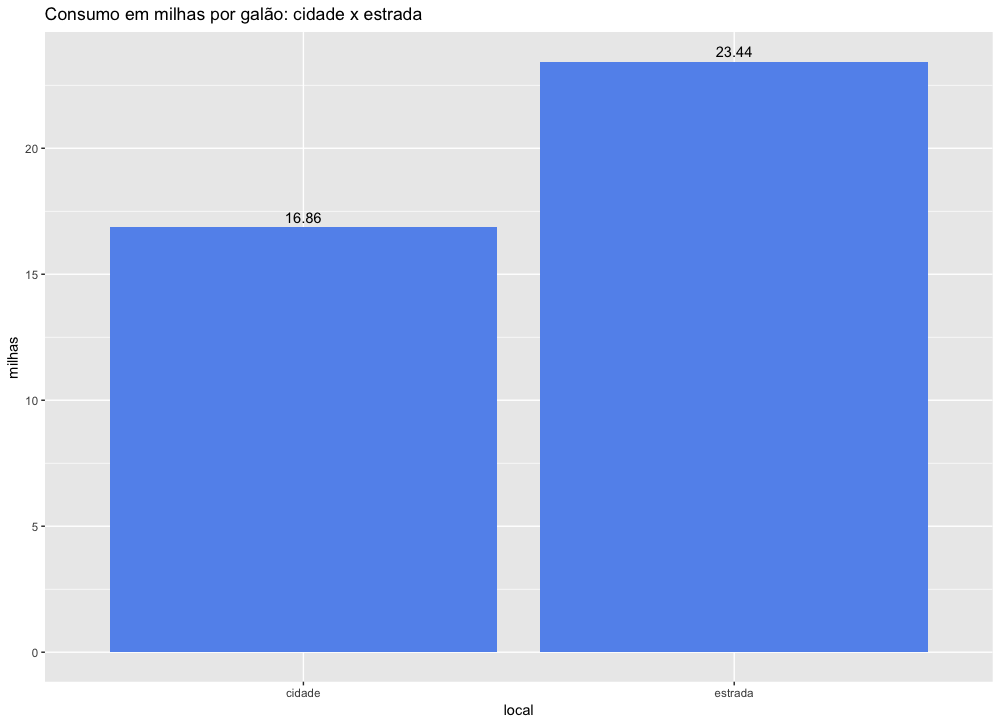

Podemos visualizar esses dados num gráfico de barras com as médias de consumo na estrada e na cidade.

1 medias.consumo <- data.frame(cidade=mean(mpg$cty), estrada=mean(mpg$hwy))

2 medias.long <- gather(medias.consumo, local, milhas, cidade, estrada)

3 ggplot(medias.long, aes(x=local, y=milhas)) +

4 geom_col(fill = "cornflowerblue") +

5 ggtitle("Consumo em milhas por galão: cidade x estrada") +

6 geom_text(aes(label=round(milhas,2)), vjust=-0.5)

7 rm(medias.consumo,medias.long)

Podemos ver que a quantidade média de milhas percorridas na estrada, com um galão, é bem maior. ou seja, com a mesma quantidade de combustível (um galão) os carros percorrem mais milhas na estrada do que na cidade.

Entretanto, examinar apenas a média ou a mediana desses valores não é suficiente. Uma situação pessoal vivida pelo biólogo Stephen Jay Gould nos mostra como a média é apenas uma parte da história. Em julho de 1982 Gould foi diagnosticado com um Mesotelioma abadominal, uma forma rara e grave de câncer, cuja média de expectativa de vida na ocasião era de 8 meses. Uma leitura superficial desses dados poderia fazer Gould pensar que iria morrer em 8 meses. Entretanto, tendo um sólido conhecimento biológico e estatístico, Gould não se satisfez em conhecer apenas o dados da mediana (ou da média) e procurou descobrir qual seria a variação desses dados, quanto alguém poderia viver com esse tipo de câncer? O que Gould descobriu depois sobre esse câncer é que algumas pessoas conseguiam sobreviver por muitos anos depois do diagnóstico, ou seja, a curva de distribuição da sobrevida era muito assimétrica à direita. Nas palavras de Gould,

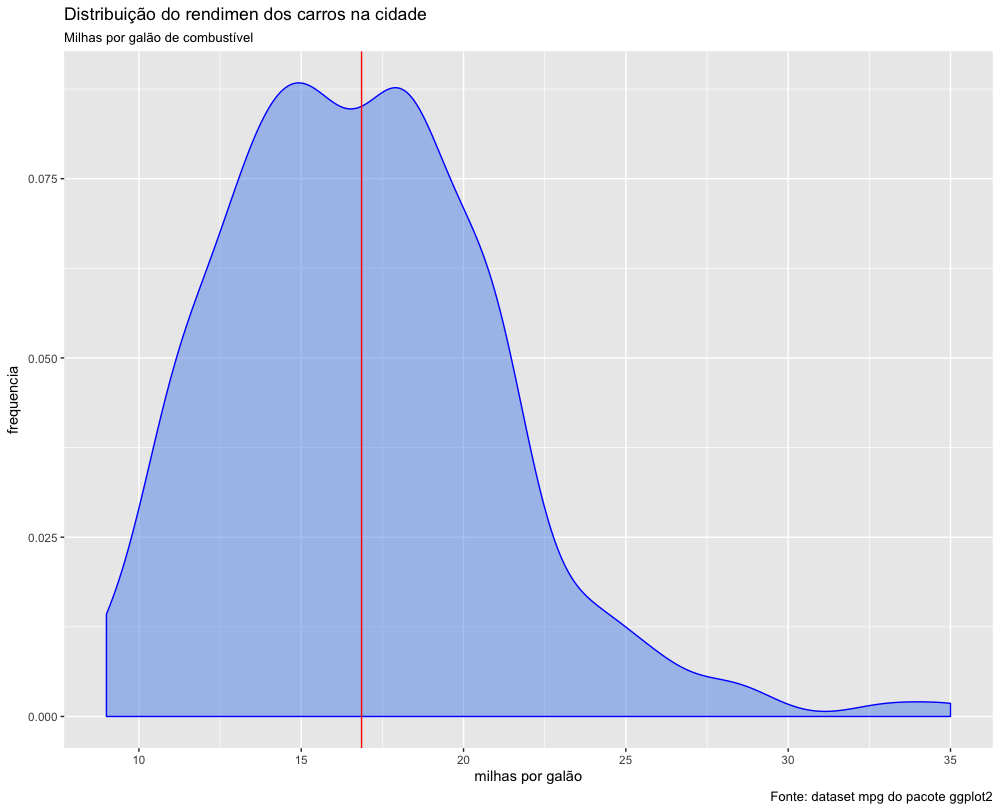

Portanto, para analisar de forma adequada um conjunto de dados, precisamos conhecer mais do que apenas a média e a mediana, precisamos conhecer a distribuição dos dados. Vamos ver como estão distribuídos os dados do rendimento dos carros na cidade.

1 ggplot(data=mpg) +

2 geom_density(aes(x=cty), fill= "cornflowerblue", col="blue", alpha=0.5) +

3 xlab("milhas por galão") +

4 ylab("frequencia") +

5 geom_vline(xintercept = mean(mpg$cty), col="red") +

6 labs(title = "Distribuição do rendimento dos carros na cidade",

7 subtitle = "Milhas por galão de combustível",

8 caption = "Fonte: dataset mpg do pacote ggplot2")

Podemos ver que a média conta apenas uma parte da história, pois existem carros que percorrem menos de 10 milhas com um galão, e alguns poucos carros que percorrem até 35 milhas com um galão de combustível.

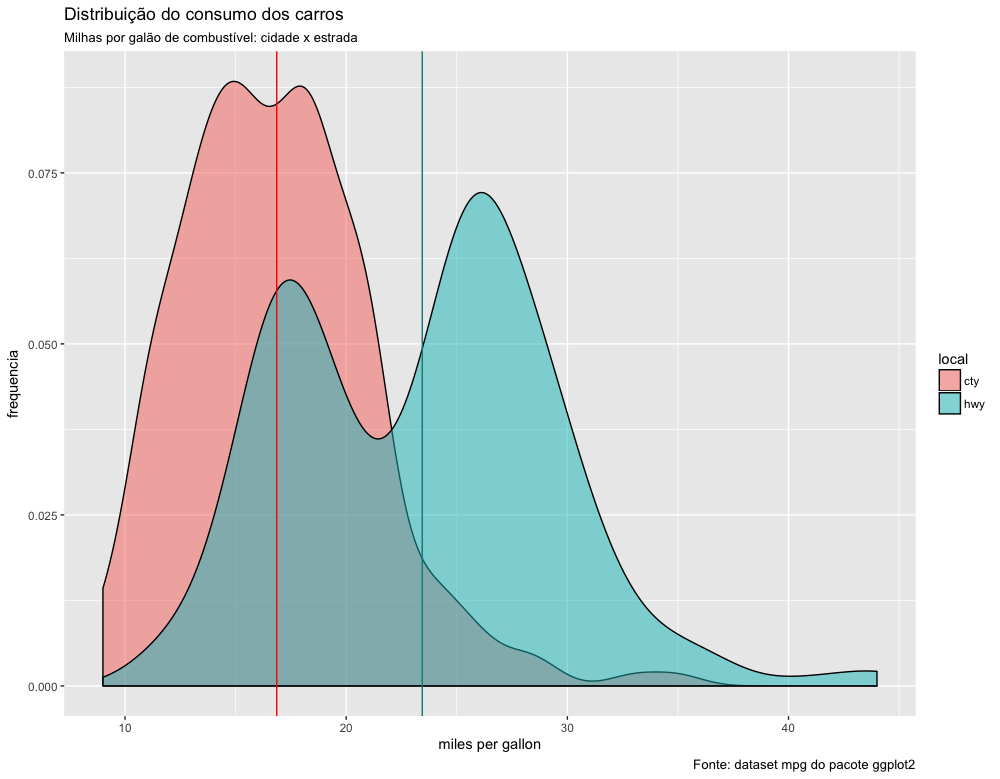

Vamos visualizar agora as duas distribuições do rendimento, na cidade e na estrada, sobrepostas uma na outra. As linhas verticais representam as médias da quantidade de milhas percorridas na cidade e na estrada. Não se preocupe em tentar entender esse código agora. Você pode simplesmente copiar e colar esse código em seu script:

1 mpg.long <- mpg %>%

2 select(cty, hwy) %>%

3 gather(key=local, value = distancia, cty, hwy)

4

5 ggplot(data=mpg.long) +

6 geom_density(aes(x=distancia, fill=local), alpha=0.5) +

7 xlab("miles per gallon") + ylab("frequencia") +

8 geom_vline(xintercept = mean(mpg$cty), col="red") +

9 geom_vline(xintercept = mean(mpg$hwy), col="cyan4") +

10 labs(title = "Distribuição do consumo dos carros",

11 subtitle = "Milhas por galão de combustível: cidade x estrada",

12 caption = "Fonte: dataset mpg do pacote ggplot2")

Podemos ver que existe uma grande sopreposição das curvas de distribuição. Não podemos dizer, portanto, que a quantidade de milhas percorridas na cidade será sempre menor que na estrada. Isso só será verdade se estivermos comparando um mesmo tipo de carro. Entretanto, alguns carros conseguem percorrer na cidade mais milhas que outros conseguem percorrer na estrada.

A distribuição dos dados ao redor da média é assimétrica à direita em ambos os conjuntos de dados, pois os valores mais extremos estão à direita.

Observe também que ambas as distribuições têm dois picos, mais evidentes na distribuição do consumo na estrada. Essa distribuição é chamada de bimodal devido a isso.

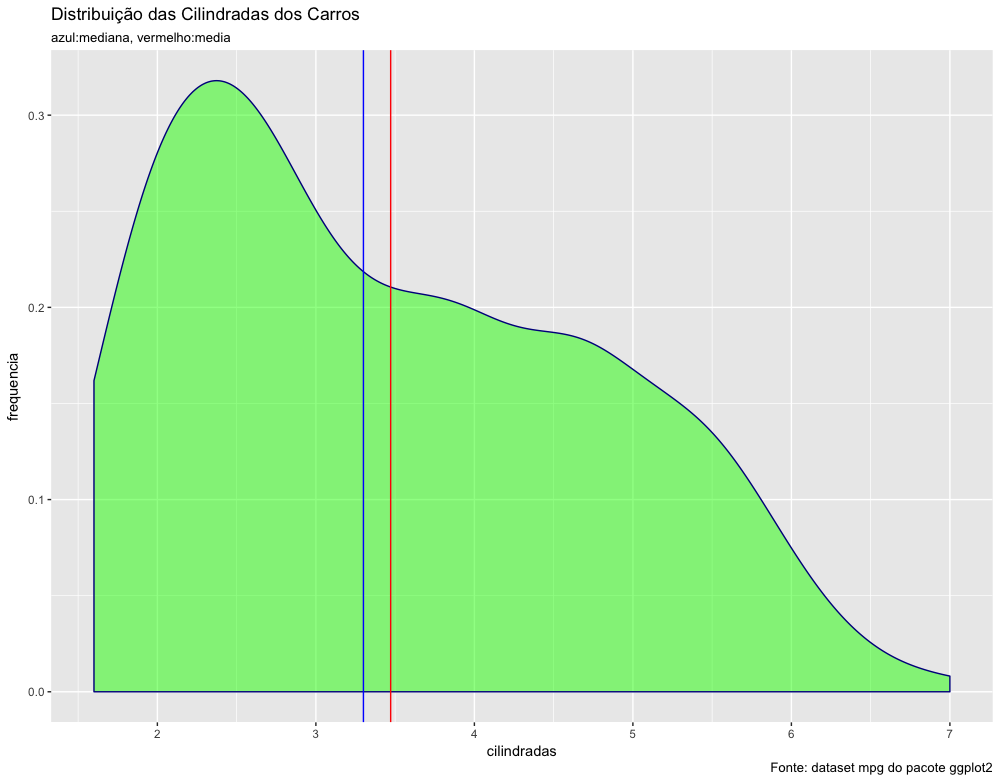

Vamos analisar agora a distribuição das cilindradas dos veículos, calculando inicialmente a média e a mediana (variável é displ).

1 > mean(mpg$displ) # media das cilindradas

2 [1] 3.471795

3

4 > median(mpg$displ) # mediana das cilindradas

5 [1] 3.3

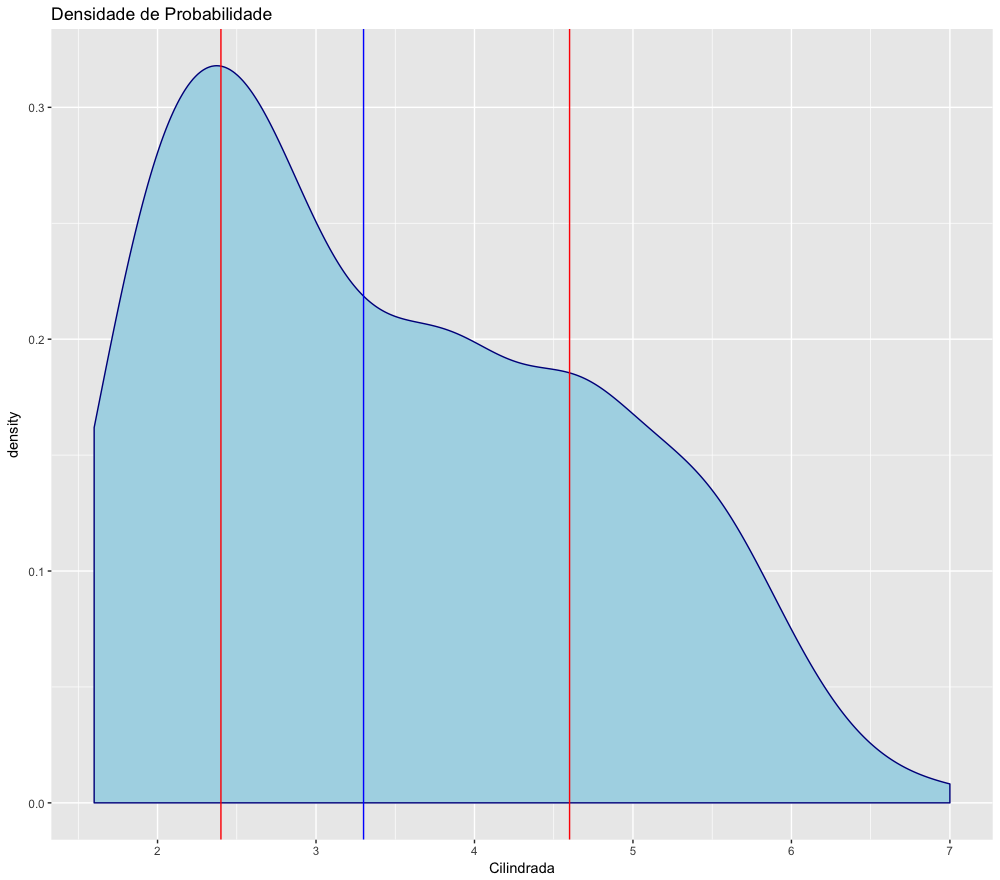

A mediana é um pouco diferente da média, ligeiramente inferior à média. Se a distribuição desse dados fosse simétrica seria esperado que a média e a mediana fossem iguais, o que não é o caso. Vamos analisar visualmente a distribuição das cilindradas com o código abaixo:

1 ggplot() +

2 geom_density(data=mpg, aes(x=displ),

3 fill="green",

4 color="darkblue",

5 alpha=0.5) +

6 geom_vline(xintercept = mean(mpg$displ),

7 col="red") +

8 geom_vline(xintercept = median(mpg$displ),

9 col="blue") +

10 xlab("cilindradas") +

11 ylab("frequencia") +

12 labs(title = "Distribuição das Cilindradas dos Carros",

13 subtitle = "azul:mediana, vermelho:media",

14 caption = "Fonte: dataset mpg do pacote ggplot2")

Veja que a distribuição é assimétrica à direita, ou seja, tem valores mais extremos à direita. Esses valores aumentam o valor da média. A mediana, por outro lado, é menos afetada por valores extremos. Você pode verificar no gráfico acima que a mediana (azul) é menor que a média (vermelho).

Visualizar num gráfico a distribuição dos dados é uma etapa chave da análise descritiva de uma pesquisa. Mas precisamos também conhecer as medidas estatísticas usadas para resumir a variação (ou dispersão) dos dados. Essas medidas são o objeto do próximo tópico.

Parte 4 - Medidas de Dispersão

1. Amplitude (range)

2. Amplitude interquartil (IQR = interquartile range)

3. Percentis (quantiles)

4. Variância

5. Desvio padrão (sd = standard deviation)

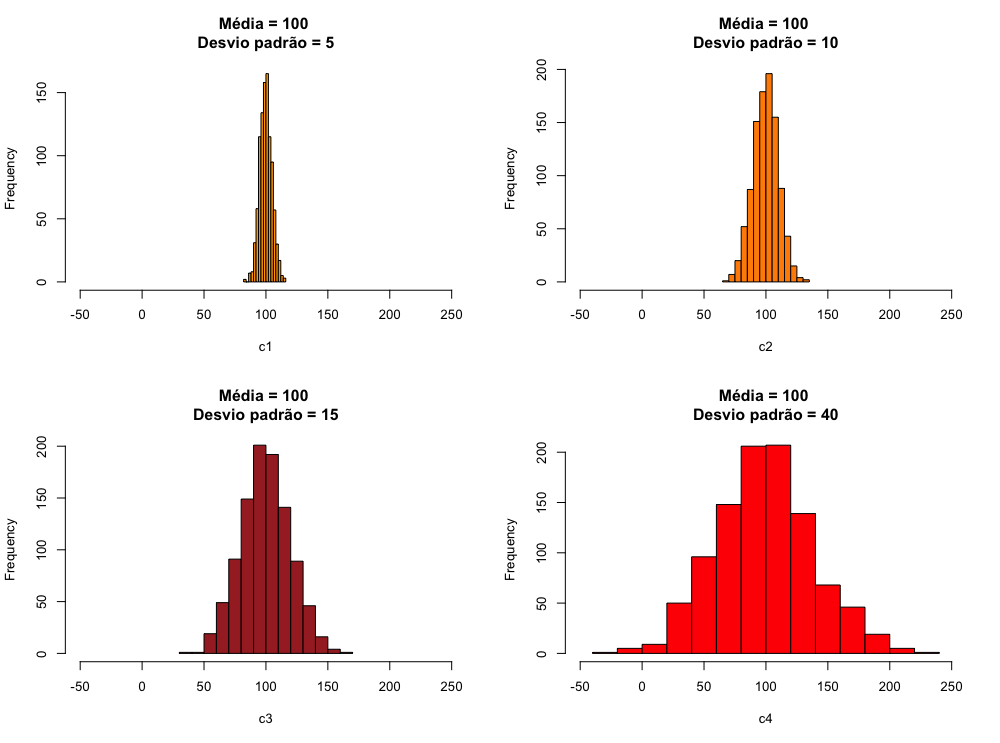

Como vimos, conhecer o ponto central de uma distribuição não é suficiente para descrever completamente um conjunto de dados. Precisamos saber também como esses dados estão distribuídos. Alguns conjuntos de dados podem ter a mesma média e serem bastante diferentes. Veja nos gráficos abaixo alguns exemplos de dados com a mesma média, mas com grande diferença no que se refere à dispersão dos dados ao redor da média.

1 # cria um conjunto com 1000 números distribuidos de forma normal, com média 100 e de\

2 svio padrão=5

3 c1 <- rnorm(1000, mean = 100, sd = 5)

4 # cria um conjunto com 1000 números distribuidos de forma normal, com média 100 e de\

5 svio padrão=10

6 c2 <- rnorm(1000, mean = 100, sd = 10)

7 # cria um conjunto com 1000 números distribuidos de forma normal, com média 100 e de\

8 svio padrão=20

9 c3 <- rnorm(1000, mean = 100, sd = 20)

10 # cria um conjunto com 1000 números distribuidos de forma normal, com média 100 e de\

11 svio padrão=40

12 c4 <- rnorm(1000, mean = 100, sd = 40)

13 # indica que iremos colocar os gráficos num grid 2x2

14 par(mfrow=c(2,2))

15

16 # gerando os histogramas coloridos.

17

18 hist(c1,

19 col = "orange",

20 breaks = 15,

21 xlim = c(-50, 250),

22 main = "Média = 100 \nDesvio padrão = 5")

23

24 hist(c2,

25 col = "darkorange",

26 breaks = 15,

27 xlim = c(-50, 250),

28 main = "Média = 100 \nDesvio padrão = 10")

29

30 hist(c3,

31 col = "brown",

32 breaks = 15,

33 xlim = c(-50, 250),

34 main = "Média = 100 \nDesvio padrão = 15")

35

36 hist(c4,

37 col = "red",

38 breaks = 15,

39 xlim = c(-50, 250),

40 main = "Média = 100 \nDesvio padrão = 40")

A necessidade descrever melhor um conjunto de dados tornou necessária a criação de medidas que descrevessem a dispersão dos dados ao redor da média.

Amplitude

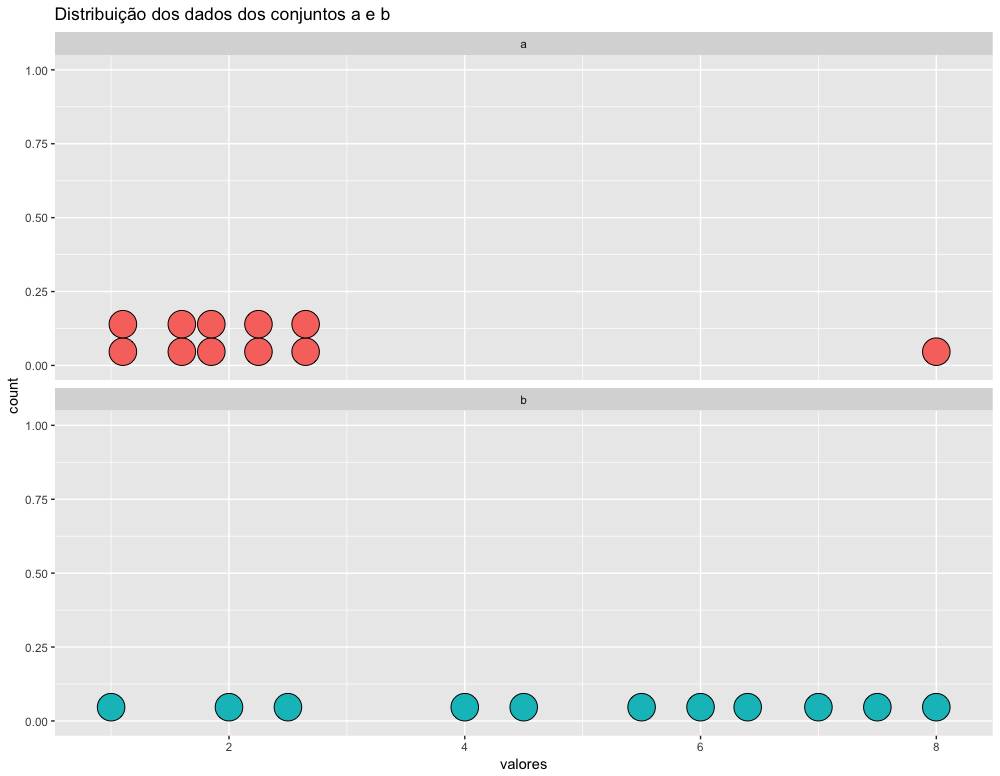

A medida mais simples de dispersão dos dados é amplitude (range em ingles). A amplitude é a diferença entre o valor máximo e o valor mínimo. Veja no exemplo abaixo uma ilustração visual do significado dessa medida. Copie e cole esse código no seu script R para ver o gráfico.

1 a <- c(1, 1.2, 1.5, 1.7, 1.8, 1.9, 2.2, 2.3, 2.6, 2.7, 8)

2 b <- c(1, 2, 2.5, 4, 4.5, 5.5, 6, 6.4, 7, 7.5, 8)

3

4 tabela <- data.frame(a, b) %>% gather(key = conjunto, value = valores, a, b)

5

6 ggplot(tabela) +

7 geom_dotplot(aes(x=valores, fill=conjunto)) +

8 facet_wrap(~conjunto, ncol=1) +

9 ggtitle("Distribuição dos dados dos conjuntos a e b") +

10 theme(legend.position="none")

Podemos ver no gráfico acima que ambos os conjuntos tem 1 como valor mínimo e 8 como valor máximo, ou seja, ambos conjuntos de dados tem amplitude igual a 7. A medida da amplitude é simplemente a diferença entre os valores máximo e mínimo. Embora os limites sejam idênticos e a amplitude seja a mesma, esses dois conjuntos tem distribuições muito diferentes.

Podemos saber quais os valores maximos e mínimos com a função range(). Essa função mostra os valores máximo e mínimo de um conjunto de dados.

1 > range(conjunto_1)

2 [1] 1 8

3

4 > range(conjunto_2)

5 [1] 1 8

Vamos descobrir quais limites superiores e inferiores da distancia percorrida pelos carros, com um galão de combustível, na cidade, usando a função range():

1 > range(mpg$cty)

2 [1] 9 35

Podemos ver que existem carros que percorrem apenas 9 milhas com um galão e outros que percorrem 35 milhas com um galão. Ou seja, a amplitude dessa amostra é de 35-9 = 26 milhas.

Entretanto, essa informação é uma medida muito grosseira, pois a amplitude é calculada usando apenas 2 dados do conjunto, os valores máximo e mínimo.

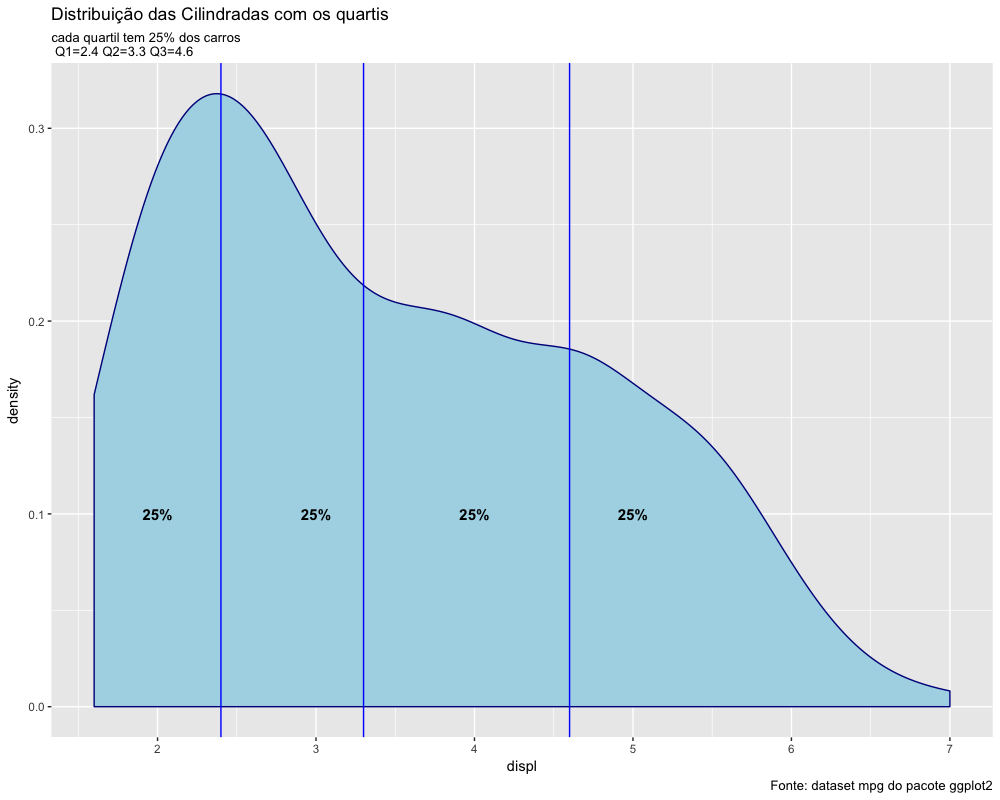

Quartis, Percentil, Qualtil e Amplitude Interquartil

A amplitude interquartil é uma medida de variabilidade, baseada na divisão de um conjunto de dados em quartis. Os quartis dividem um conjunto de dados ordenados em quatro partes iguais. Os valores que separam partes são chamados de primeiro, segundo e terceiro quartis, e são denotados por Q1, Q2 e Q3, respectivamente. O primeiro quartil (Q1) é o valor abaixo do qual estão 25% dos dados, o segundo quartil (Q2) é o valor abaixo do qual estão 50% do dados e o terceiro quartil (Q3) é o valor abaixo do qual estão 75% dos dados.

A divisão dos conjunto de dados em percentuais é o que se denomina de percentil. Os percentis mais famosos são:

- 1º quartil ( = percentil 25%)

- 2º quartil ( = percentil 50% = mediana)

- 3º quartil (= percentil 75%).

Em estatística é comum usar o termo quantil para se referir ao percentil. A única diferença é que o quando usamos percentil usamos o número em sua forma de porcentagem (percentil 50%) e quando usamos o termo quantil usamos o número em sua forma decimal (quantil 0.5). O R tem uma função denominada quantile() para que você possa saber o quantil (ou percentil) que desejar.

Vamos calcular os quantis mais importantes, que são o primeiro, segundo e terceiro quartis: Q1, Q2 e Q3 no conjunto de dados da cilindrada dos carros no dataset mpg.

1 > Q1 <- quantile(mpg$displ, probs = 0.25)

2 > Q2 <- quantile(mpg$displ, probs = 0.50)

3 > Q3 <- quantile(mpg$displ, probs = 0.75)

4

5 > Q1

6 25%

7 2.4

8

9 > Q2

10 50%

11 3.3

12

13 > Q3

14 75%

15 4.6

Podemos ver que o 2º quartil é exatamente a própria mediana. O gráfico abaixo ajuda a visualizar o significado dos quartis. O código abaixo plota um gráfico para continuar nossa análise:

1 ggplot() +

2 geom_density(data=mpg,

3 aes(x=displ),

4 fill="lightblue",

5 color="darkblue")+

6 geom_vline(xintercept = Q1,

7 col="blue") +

8 geom_vline(xintercept = Q2,

9 col="blue") +

10 geom_vline(xintercept = Q3,

11 col="blue") +

12 theme(plot.title = element_text(lineheight=0.8)) +

13 annotate("text",

14 x=2,

15 y=0.1,

16 label= "25%",

17 color="black",

18 fontface=2,

19 size=4) +

20 annotate("text",

21 x=3,

22 y=0.1,

23 label= "25%",

24 color="black",

25 fontface=2,

26 size=4) +

27 annotate("text", x=4,

28 y=0.1,

29 label= "25%",

30 color="black",

31 fontface=2,

32 size=4) +

33 annotate("text",

34 x=5,

35 y=0.1,

36 label= "25%",

37 color="black",

38 fontface=2,

39 size=4) +

40 labs(title = "Distribuição das Cilindradas com os quartis",

41 subtitle = "cada quartil tem 25% dos carros \n Q1=2.4 Q2=3.3 Q3=4.6",

42 caption = "Fonte: dataset mpg do pacote ggplot2")

Na estatística descritiva, a amplitude interquartil (IQR) é uma medida de dispersão estatística, sendo igual à diferença entre o quartil superior (Q3) e quartil inferior (Q1). É também chamada de midspread ou middle 50%, ou H-spread.

IQR = Q3 - Q1.

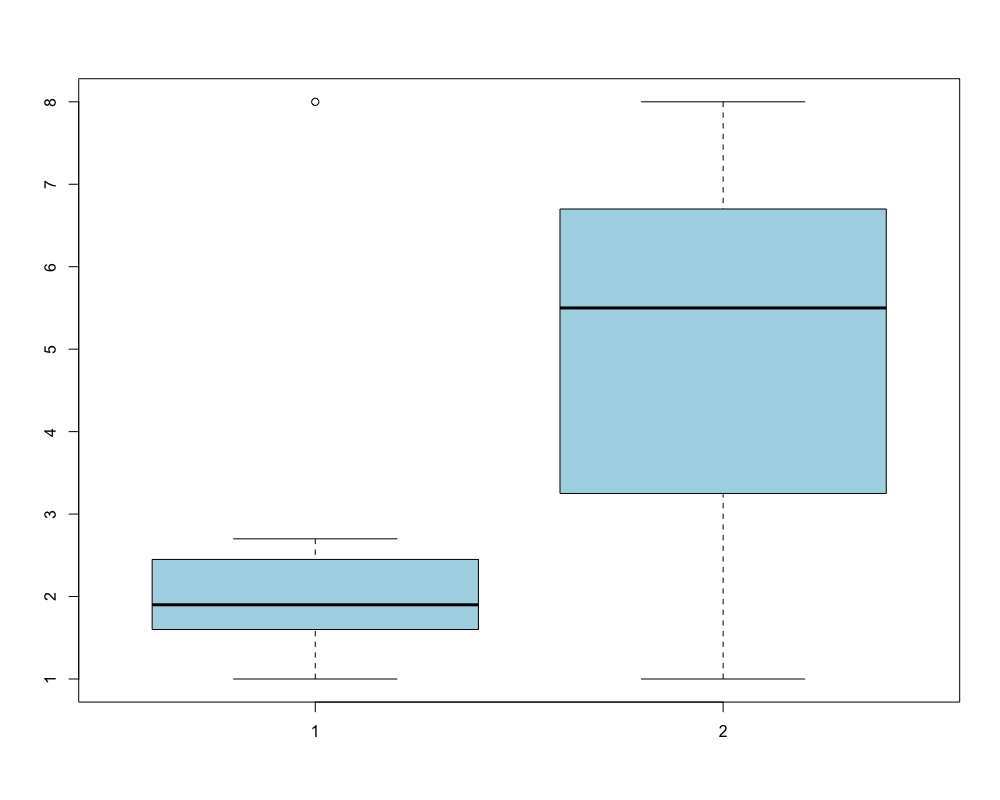

Em outras palavras, a amplitude interquartil (IQR) é 3º quartil menos o 1º quartil. Para compreender o que é o IQR observe os seguintes conjuntos de dados:

1 a <- c(1, 1.2, 1.5, 1.7, 1.8, 1.9, 2.2, 2.3, 2.6, 2.7, 8)

2 b <- c(1, 2, 2.5, 4, 4.5, 5.5, 6, 6.4, 7, 7.5, 8)

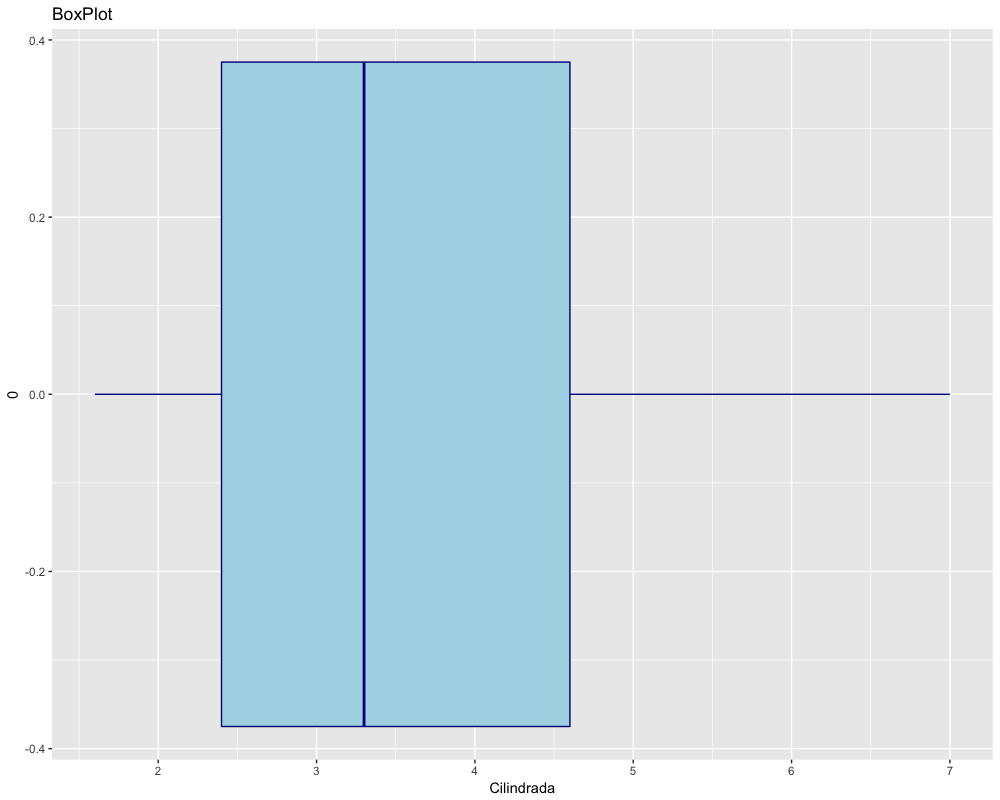

Esses dados tem a mesma amplitude, mas seu IQR é bastante diferente e pode ser visualizado num gráfico de boxplot como abaixo:

1 boxplot(a,b,col="lightblue")

Num boxplot, a caixa representa os 50% dos dados centrais do conjunto, ou seja, os limites das caixas de um boxplot são o 1º e o 3º quartis.

A medida IQR (amplitude interquartil) é mais robusta que a amplitude simples, pois desconsidera os 25% de dados superiores e os 25 inferiores.

Agora vamos criar um grafico de densidade e um boxplot com os dados da cilindrada para visualizarmos essas medidas. O código abaixo gera os gráficos e coloca esses gráficos nos objetos plot1 e plot2:

1 plot1 <- ggplot() +

2 geom_density(data=mpg,

3 aes(x=displ),

4 fill="lightblue",

5 color="darkblue") +

6 xlab("Cilindrada") +

7 geom_vline(xintercept = Q1, col="red") +

8 geom_vline(xintercept = Q3, col="red") +

9 geom_vline(xintercept = Q2, col="blue") +

10 theme(plot.title =element_text(lineheight=0.8)) +

11 ggtitle("Densidade de Probabilidade")

12

13 plot2 <- ggplot() +

14 geom_boxplot(data=mpg,

15 aes(x=0,y=displ),

16 fill="lightblue",

17 color="darkblue") +

18 ylab("Cilindrada") +

19 ggtitle("BoxPlot") +

20 coord_flip()

Para plotar os gráficos apenas digite os nomes dos objetos como abaixo:

1 plot1

2 plot2

O R tem funções para calcular o percentil que você desejar, mas como é um software estatístico, a função é quantil() e o não percentil. Para obter o valor correspondente ao quantil desejado, é preciso fornecer como argumento da função o objeto com os dados e o quantil desejado. O resultado é o valor que corresponde àquele quantil.

Vamos testar calculando o quantil 0.5, que o mesmo que a mediana, usando os dados das cilindradas:

Calculando o quantil 0.5 (= percentil 50% = mediana):

1 > quantile(mpg$displ, 0.5)

2 50%

3 3.3

Calculando a mediana, para verificarmos que o resultado é o mesmo:

1 > median(mpg$displ)

2 [1] 3.3

O significado da mediana = 3.3

- 50% dos carros nesse dataset tem sua cilindrada acima de 3.3

- 50% dos carros nesse dataset tem sua cilindrada abaixo de 3.3

Variância e Desvio Padrão

Como vimos, a amplitude interquartil (IQR) é uma medida mais interessante que a mera amplitude, pois descarta os valores extremos, sendo assim menos sensível a outliers, ou seja, é uma medida considerada mais robusta que a simples amplitude. entretanto, o IQR também sofre do mesmo problema que a amplitude: é um cálculo que só usa dois dados, deixando muitos dados fora da análise.

Precisamos encontrar uma nova medida que represente melhor a dispersão do conjunto de dados, usando todos os dados desse conjunto.